Modèles de classification dans la bibliothèque Scikit-Learn et leur export vers ONNX

Le développement de la technologie a conduit à l'émergence d'une approche fondamentalement nouvelle de la construction d'algorithmes de traitement des données. Avant cela, la résolution de chaque tâche spécifique nécessitait une formalisation claire et le développement d'algorithmes correspondants.

Avec l'apprentissage automatique, ou machine learning, l'ordinateur apprend à trouver les meilleurs moyens de traiter les données par lui-même. Les modèles d'apprentissage automatique peuvent résoudre avec succès des tâches de classification (lorsqu'il existe un ensemble fixe de classes et que l'objectif est de déterminer les probabilités d'appartenance à chaque classe d'un ensemble donné de caractéristiques) et des tâches de régression (lorsque l'objectif est d'estimer une valeur numérique de la variable cible sur la base d'un ensemble donné de caractéristiques). Des modèles de traitement de données plus complexes peuvent être élaborés à partir de ces composants fondamentaux.

La bibliothèque Scikit-learn fournit une multitude d'outils pour la classification et pour la régression. Le choix de méthodes et de modèles spécifiques dépend des caractéristiques des données, car différentes méthodes peuvent avoir une efficacité variable et fournir des résultats différents en fonction de la tâche.

Dans le communiqué de presse "ONNX Runtime is now open source", il est indiqué que le Runtime ONNX supporte également le profil ONNX-ML :

Le profil ONNX-ML est une partie d'ONNX conçue spécifiquement pour les modèles d'apprentissage automatique (Machine Learning, ML). Il est destiné à décrire et à représenter divers types de modèles ML, tels que la classification, la régression, le regroupement et autres, dans un format pratique qui peut être utilisé sur diverses plateformes et environnements qui supportent ONNX. Le profil ONNX-ML simplifie la transmission, le déploiement et l'exécution des modèles d'apprentissage automatique, les rendant plus accessibles et portables.

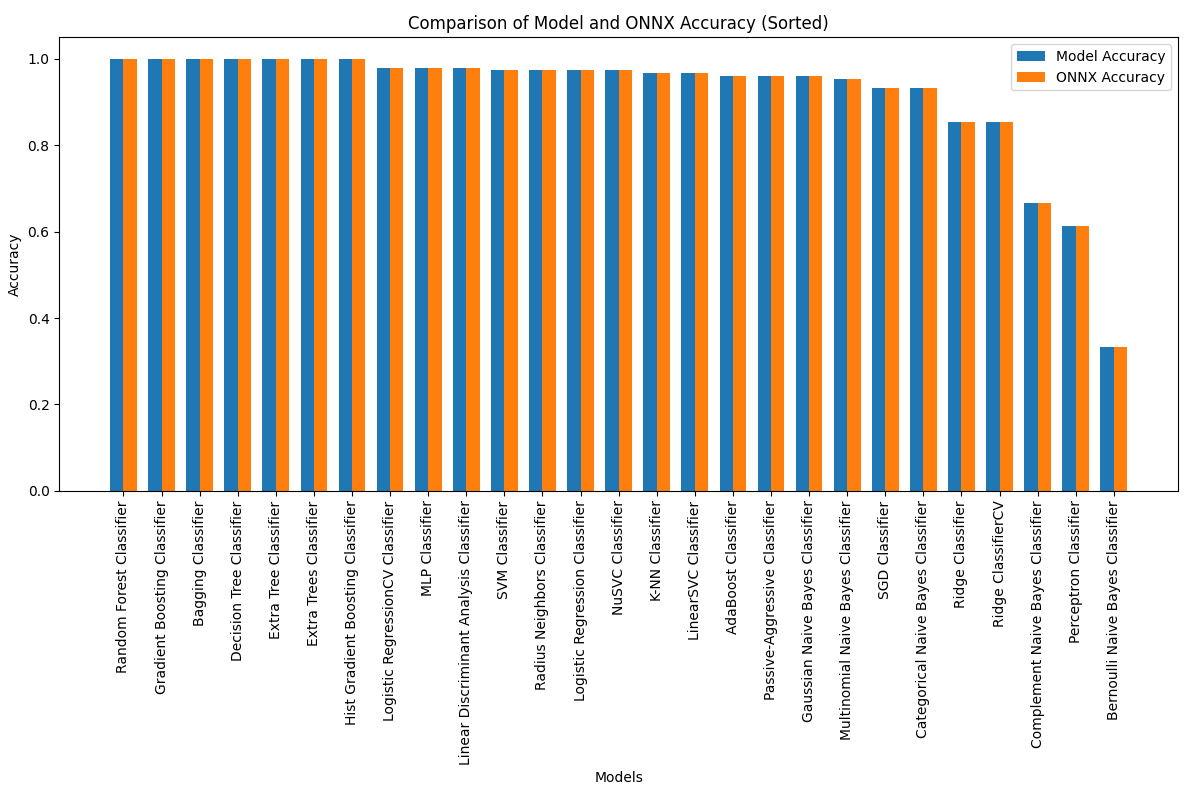

Dans cet article, nous allons explorer l'application de tous les modèles de classification dans le paquet Scikit-learn pour résoudre la tâche de classification de l'Iris de Fisher. Nous tenterons également de convertir ces modèles au format ONNX et d'utiliser les modèles résultants dans les programmes MQL5.

Nous comparerons également la précision des modèles originaux avec leurs versions ONNX sur l'ensemble des données Iris.

Table des Matières

- 1. Iris de Fisher

- 2. Modèles de Classification

Liste des Classificateurs Scikit-learn

Différentes Représentations de Sortie des Modèles iris.mqh - 2.1. Classificateur SVC

2.1.1. Code de Création du Modèle de Classification SVC

2.1.2. Code MQL5 pour travailler avec le modèle de classification SVC

2.1.3. Représentation ONNX du modèle de classification SVC - 2.2. Classificateur LinearSVC

2.2.1. Code de création du modèle de classification LinearSVC

2.2.2. Code MQL5 pour travailler avec le modèle de classification LinearSVC

2.2.3. Représentation ONNX du modèle de classification LinearSVC - 2.3. NuSVC Classifier

2.3.1. Code de création du modèle de classification NuSVC

2.3.2. Code MQL5 pour travailler avec le modèle de classification NuSVC

2.3.3. Représentation ONNX du modèle de classification NuSVC - 2.4. Classificateur Radius Neighbors

2.4.1. Code de création du modèle de classification Radius Neighbors

2.4.2. Code MQL5 pour travailler avec le modèle de classification Radius Neighbors

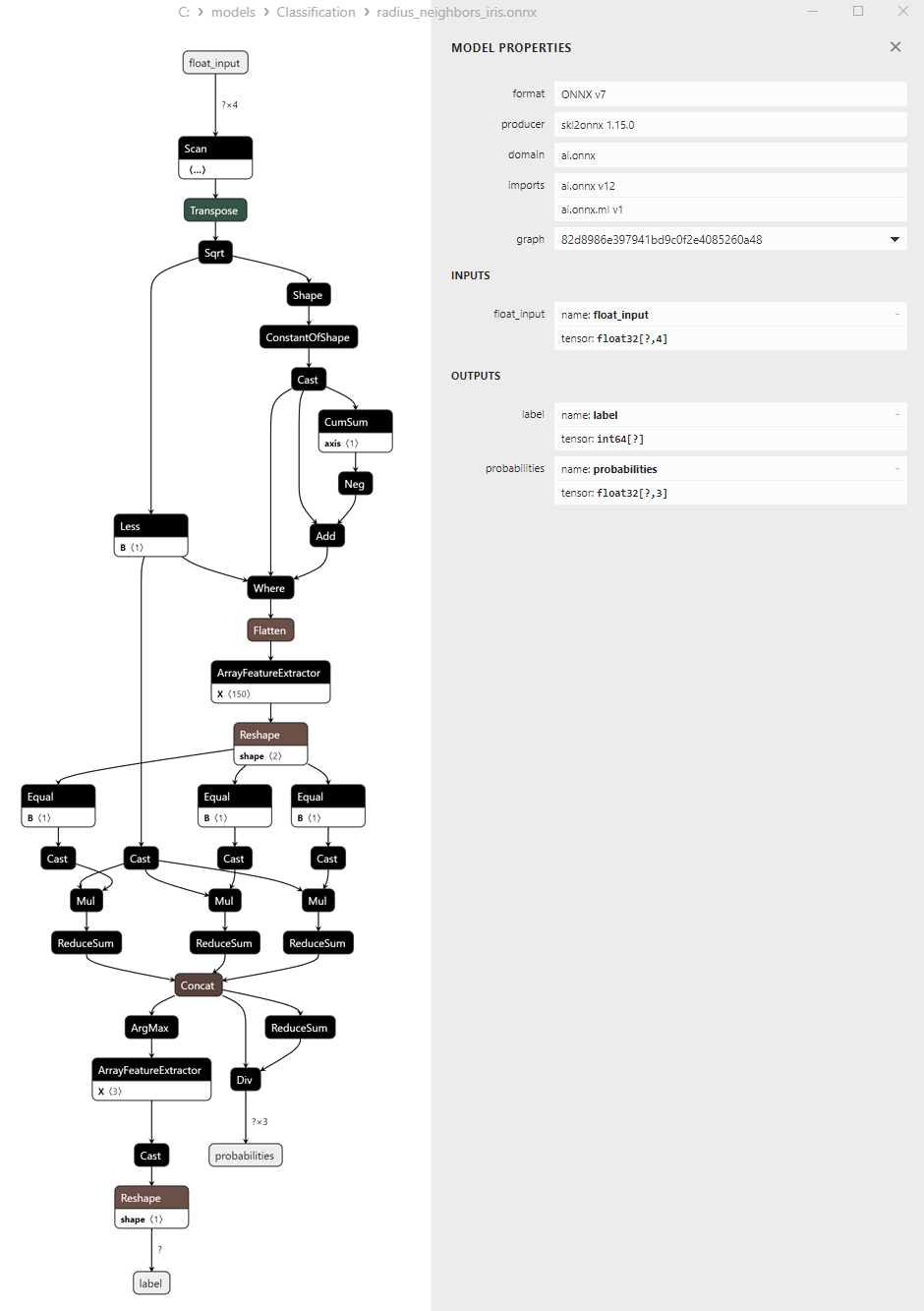

2.3.3. Représentation ONNX du modèle de classification Radius Neighbors - 2.5. Classificateur Ridge

2.5.1. Code de création du modèle de classification Ridge

2.5.2. Code MQL5 pour travailler avec le modèle de classification Ridge

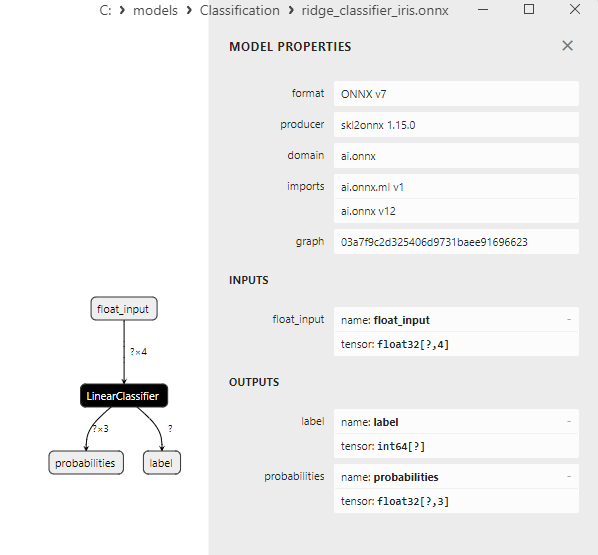

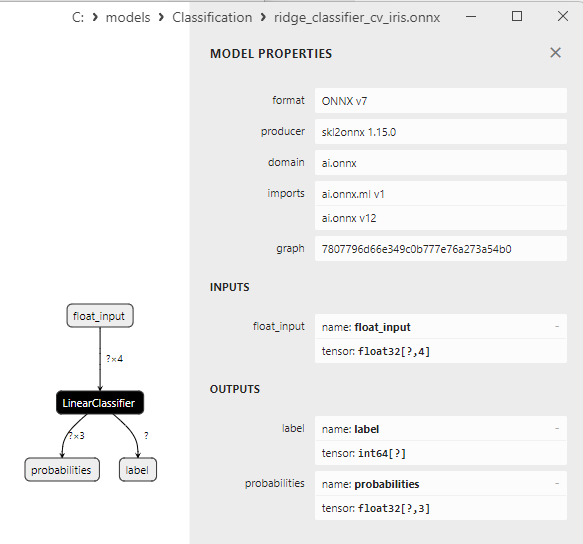

2.5.3. Représentation ONNX du modèle de classification Ridge - 2.6. RidgeClassifierCV

2.6.1. Code de création du modèle Ridge ClassifierCV

2.6.2. Code MQL5 pour travailler avec le modèle Ridge ClassifierCV

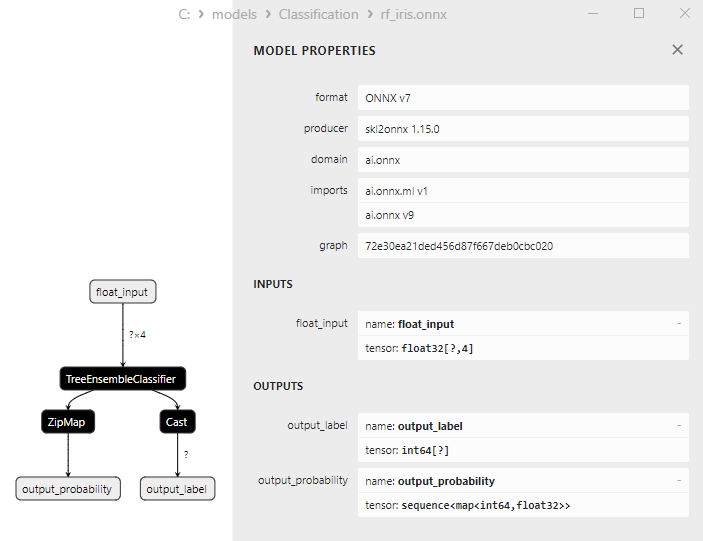

2.6.3. Représentation ONNX du modèle Ridge ClassifierCV - 2.7. Classificateur Random Forest

2.7.1. Code pour la création du modèle de classification Random Forest

2.7.2. Code MQL5 pour travailler avec le modèle de classification Random Forest

2.7.3. Représentation ONNX du modèle de classification Random Forest - 2.8. Classificateur Gradient Boosting

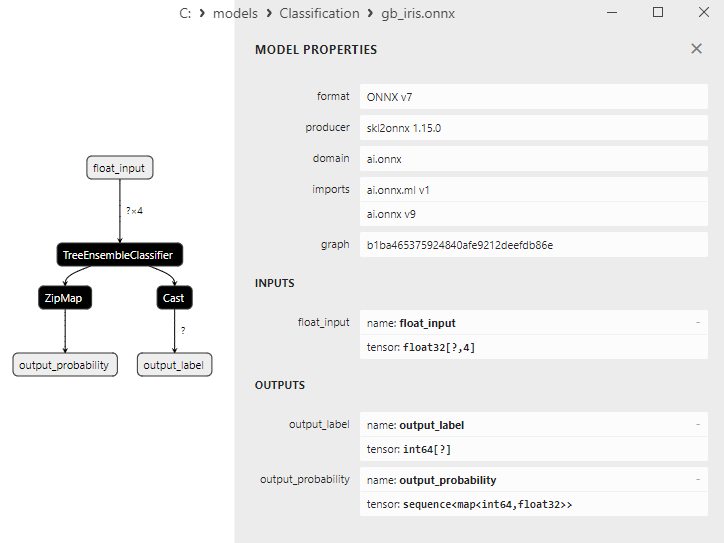

2.8.1. Code pour la création du Modèle de Classification Gradient Boosting

2.8.2. Code MQL5 pour Travailler avec le Modèle de Classification Gradient Boosting

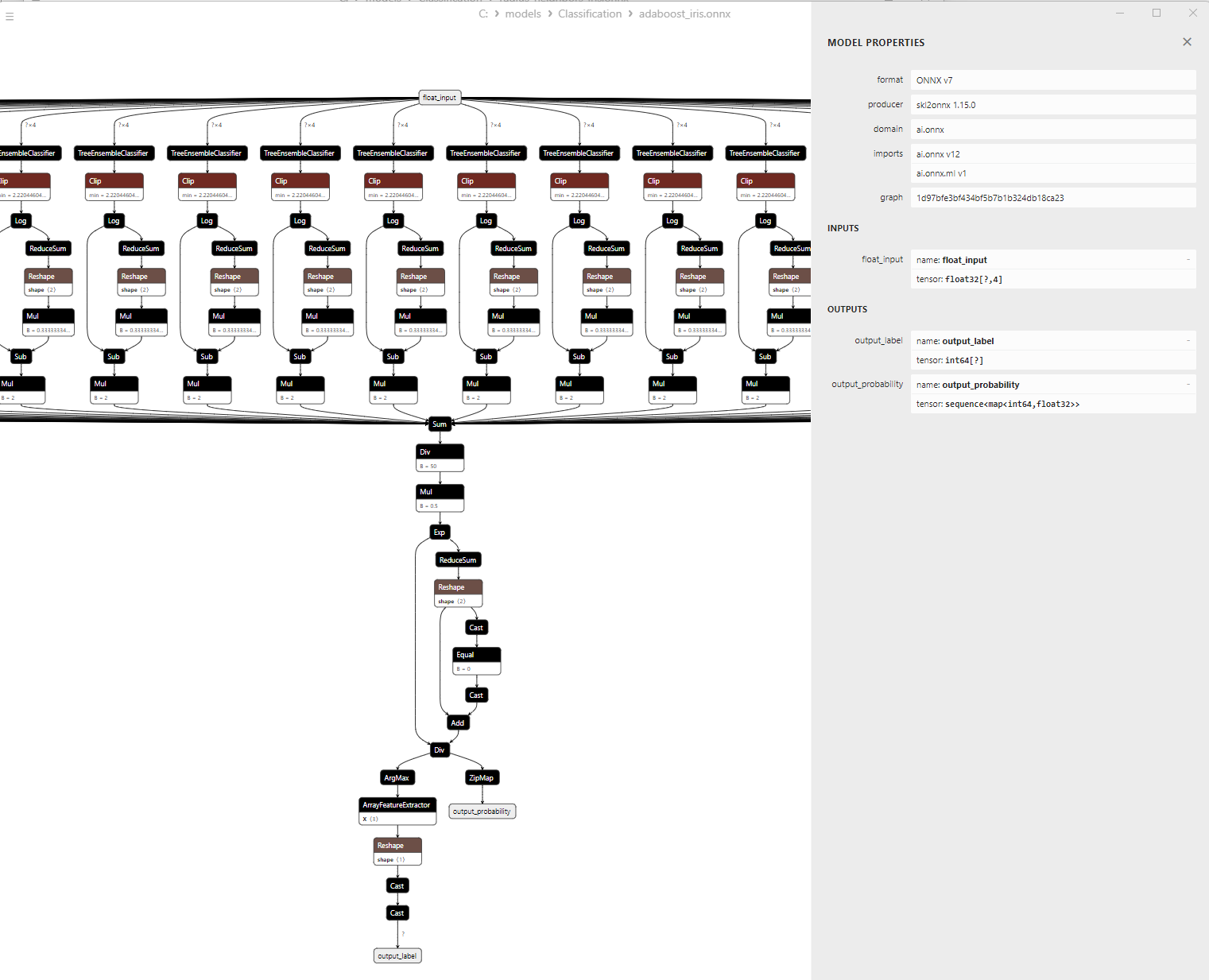

2.8.3. Représentation ONNX du Modèle de Classification Gradient Boosting - 2.9. Classificateur Boosting Adaptative

2.9.1. Code pour la Création du Modèle de Classificateur Boosting Adaptative

2.9.2. Code MQL5 pour Travailler avec le Modèle de Classification Adaptive Boosting

2.9.3. Représentation ONNX du Modèle de Classification Adaptative Boosting - 2.10. Classificateur Bootstrap Aggregating

2.10.1. Code pour la Création du Modèle Bootstrap Aggregating Classifier

2.10.2. Code MQL5 pour Travailler avec le Modèle Bootstrap Aggregating Classifier

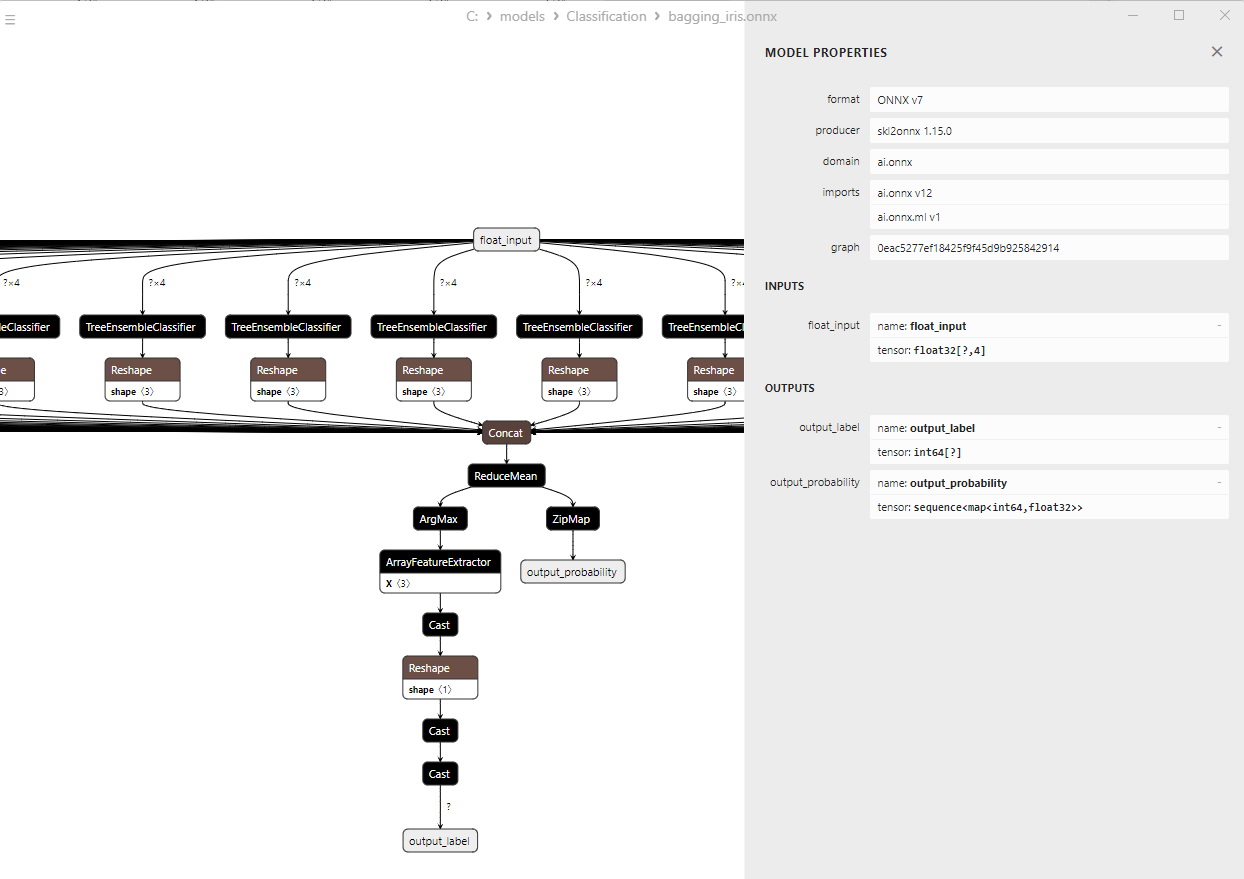

2.10.3. Représentation ONNX du Modèle de Classification Bootstrap Aggregating - 2.11. Classificateur K-Nearest Neighbors (K-NN)

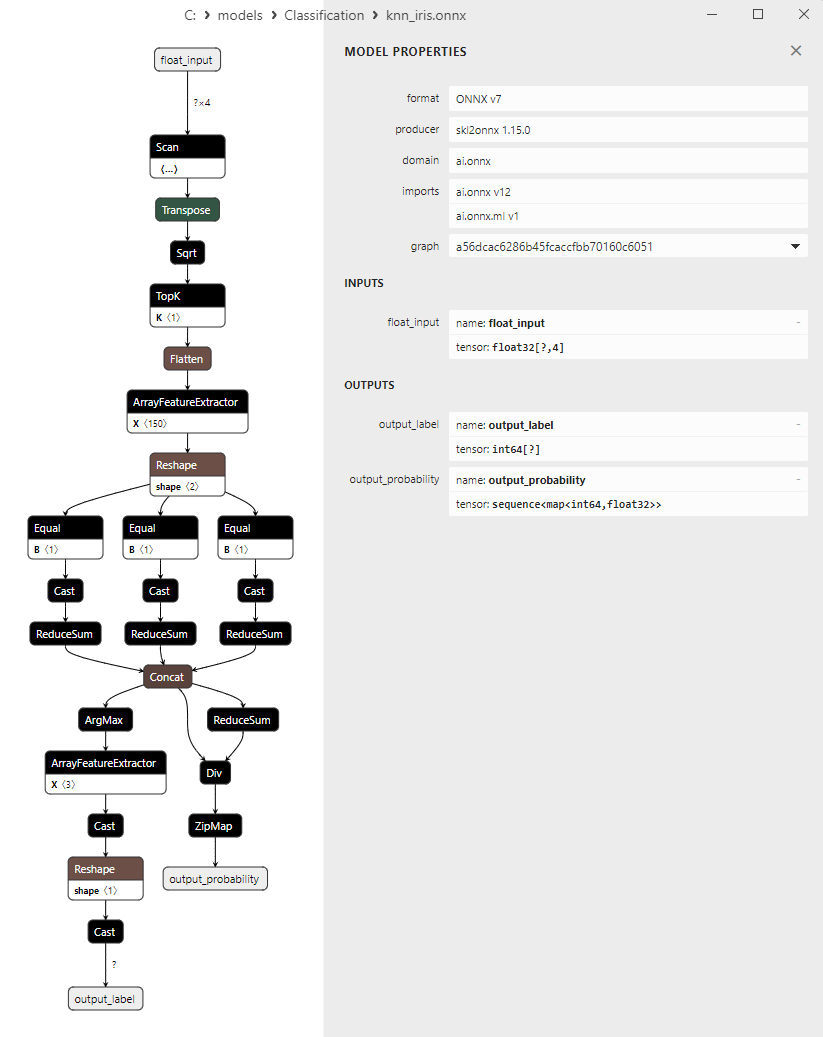

2.11.1. Code pour la Création du Modèle de Classification K-NN (K-Nearest Neighbors)

2.11.2. Code MQL5 pour Travailler avec le Modèle de Classification K-NN (K-Nearest Neighbors)

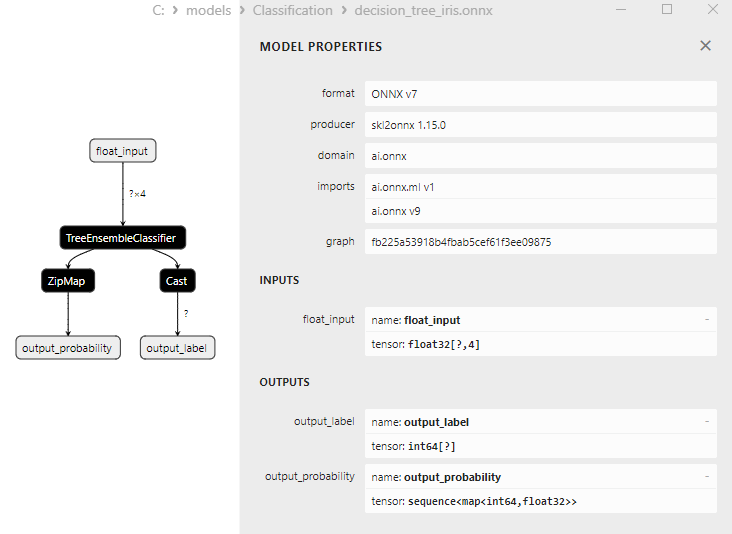

2.11.3. Représentation ONNX du Modèle de Classification K-NN (K-NN) - 2.12. Classificateur Decision Tree (Arbre de Décision)

2.12.1. Code pour la Création du Modèle de Classification Decision Tree

2.12.2. Code MQL5 pour Travailler avec le Modèle de Classification Decision Tree

2.12.3. Représentation ONNX du Modèle de Classification Decision Tree - 2.13. Classificateur de Régression Logistique (Logistic Regression)

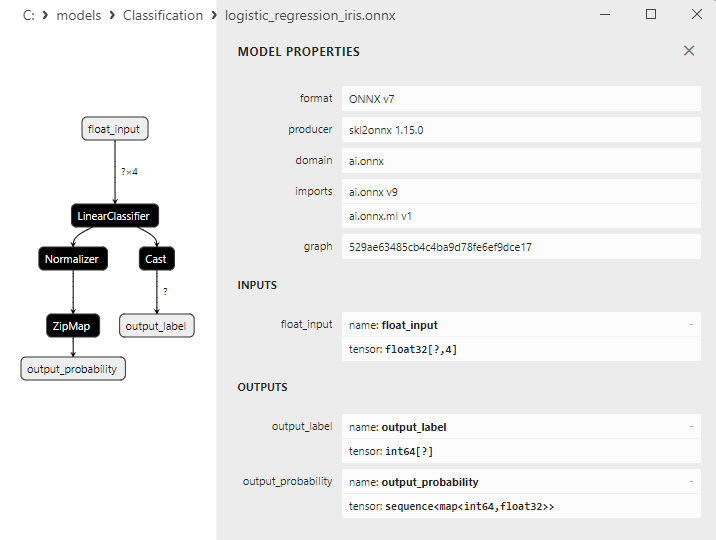

2.13.1. Code de Création du Modèle de Classification Logistic Regression

2.13.2. Code MQL5 pour Travailler avec le Modèle Logistic Regression

2.13.3. Représentation ONNX du Modèle de Classification Logistic Regression - 2.14. Classificateur LogisticRegressionCV

2.14.1. Code de Création du Modèle de Classification LogisticRegressionCV

2.14.2. Code MQL5 pour Travailler avec le Modèle de Classification LogisticRegressionCV

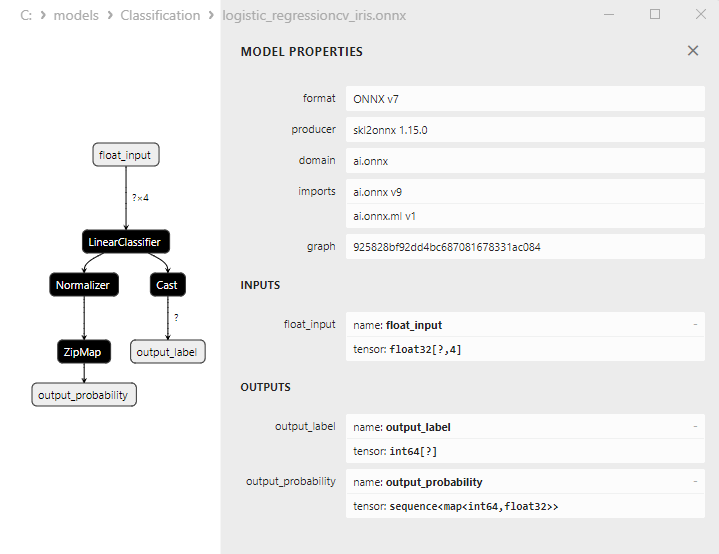

2.14.3. Représentation ONNX du Modèle de Classification LogisticRegressionCV - 2.15. Classificateur Passif-Agressif (PA)

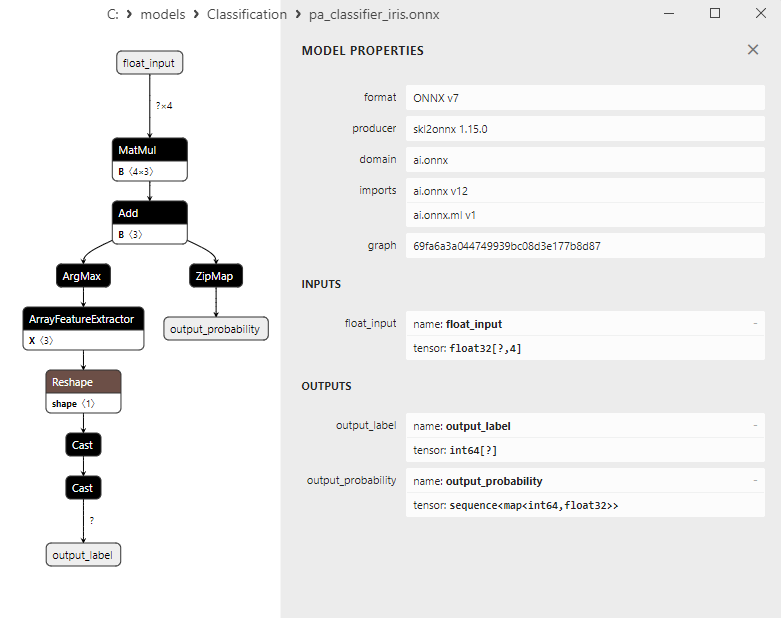

2.15.1. Code pour la Création du Modèle de Classificateur Passif-Agressif (PA)

2.15.2. Code MQL5 pour Travailler avec le Modèle de Classificateur Passif-Agressif (PA)

2.15.3. Représentation ONNX du Modèle de Classificateur Passif-Agressif (PA) - 2.16. Classificateur Perceptron

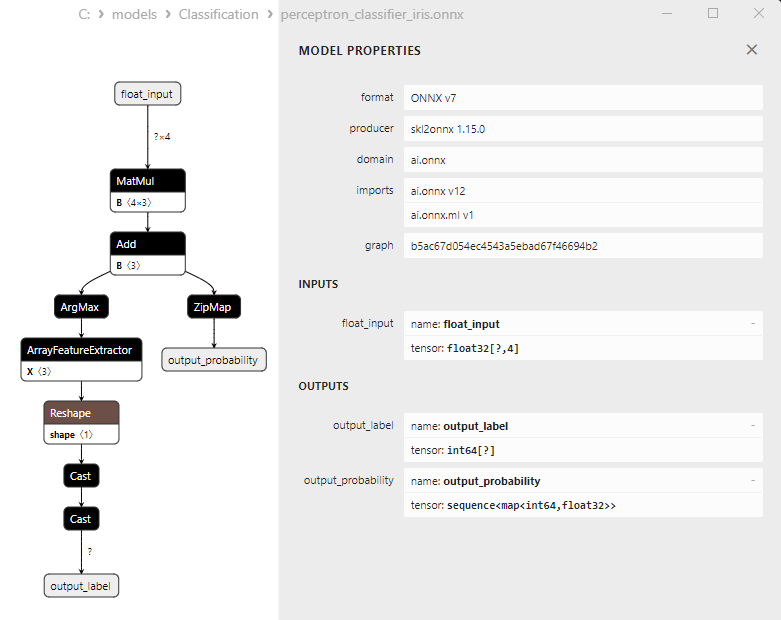

2.16.1. Code de Création du Modèle de Classification Perceptron

2.16.2. Code MQL5 pour Travailler avec le Modèle de Classification Perceptron

2.16.3. Représentation ONNX du Modèle de Classification Perceptron - 2.17. Classificateur Stochastic Gradient Descent

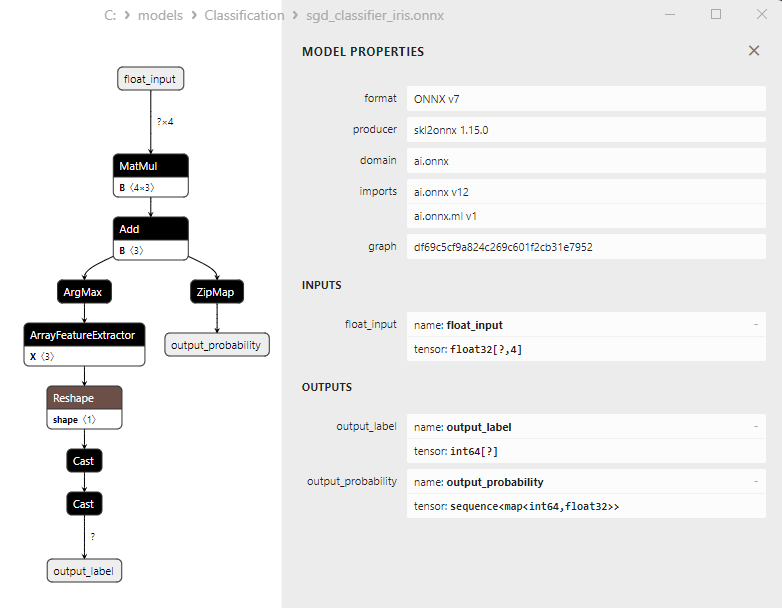

2.17.1. Code de Création du Modèle de Classification Stochastic Gradient Descent

2.17.2. Code MQL5 pour Travailler avec le Modèle de Classification Stochastic Gradient Descent

2.17.3. Représentation ONNX du Modèle de Classification Stochastic Gradient Descent - 2.18. Classificateur Gaussian Naive Bayes (GNB)

2.18.1. Code de Création du Modèle de Classification Gaussian Naive Bayes (GNB)

2.18.2. Code MQL5 pour Travailler avec le Modèle de Classification Gaussian Naive Bayes (GNB)

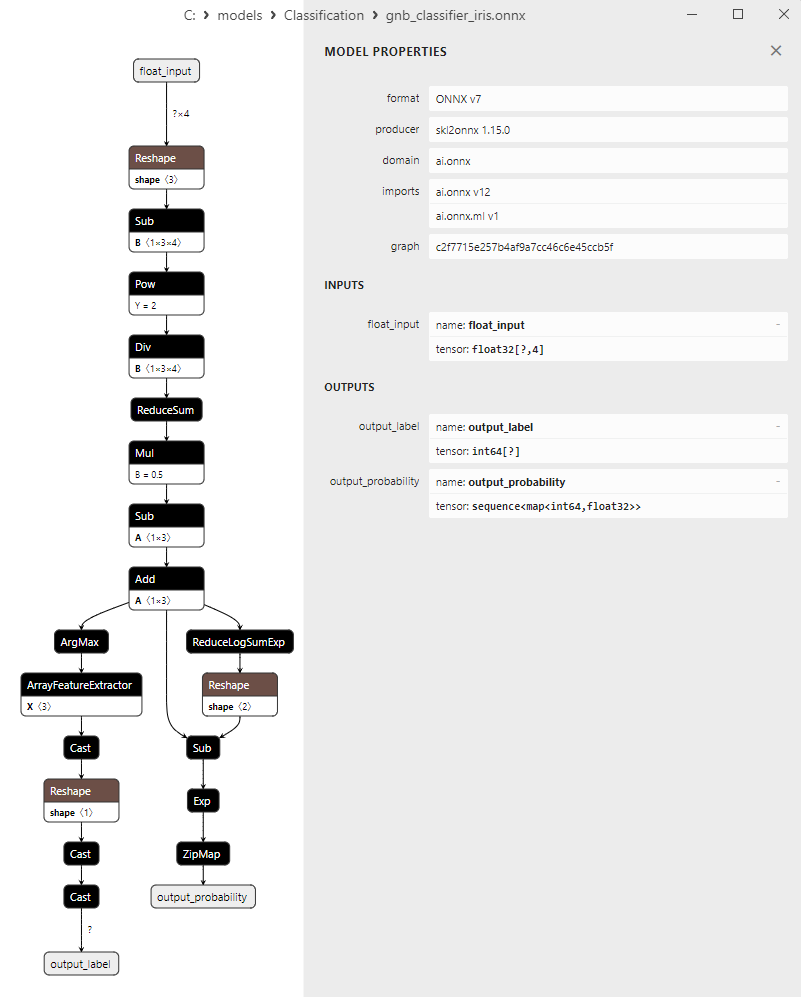

2.18.3. Représentation ONNX du Modèle de Classification Gaussian Naive Bayes (GNB) - 2.19. Classificateur Multinomial Naive Bayes (MNB)

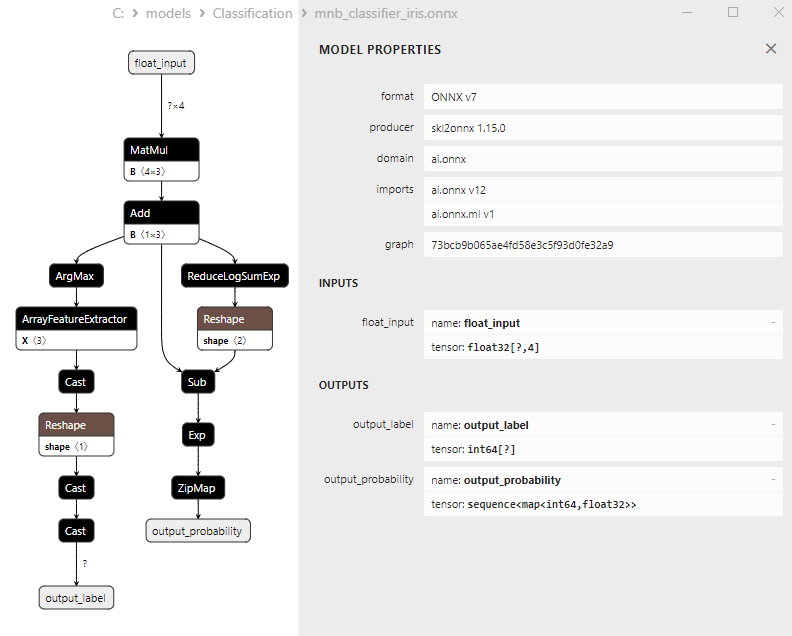

2.19.1. Code de Création du Modèle de Classification Multinomial Naive Bayes (MNB)

2.19.2. Code MQL5 pour Travailler avec le Modèle de Classification Multinomial Naive Bayes (MNB)

2.19.3. Représentation ONNX du Modèle de Classification Multinomial Naive Bayes (MNB) - 2.20. Classificateur Complement Naive Bayes (CNB)

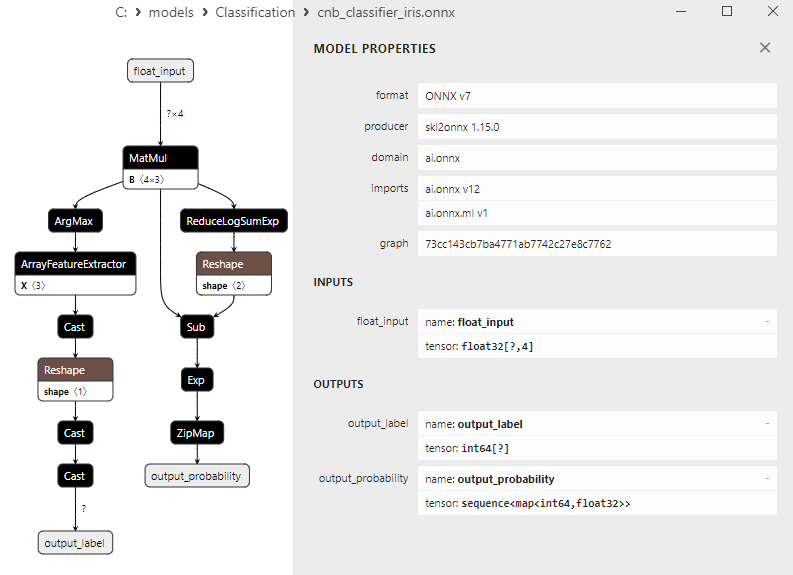

2.20.1. Code pour la Création du Modèle de Classification Complement Naive Bayes (CNB)

2.20.2. Code MQL5 pour Travailler avec le Modèle de Classification Complement Naive Bayes (CNB)

2.20.3. Représentation ONNX du Modèle de Classification Complement Naive Bayes (CNB) - 2.21. Classificateur Bernoulli Naive Bayes (BNB)

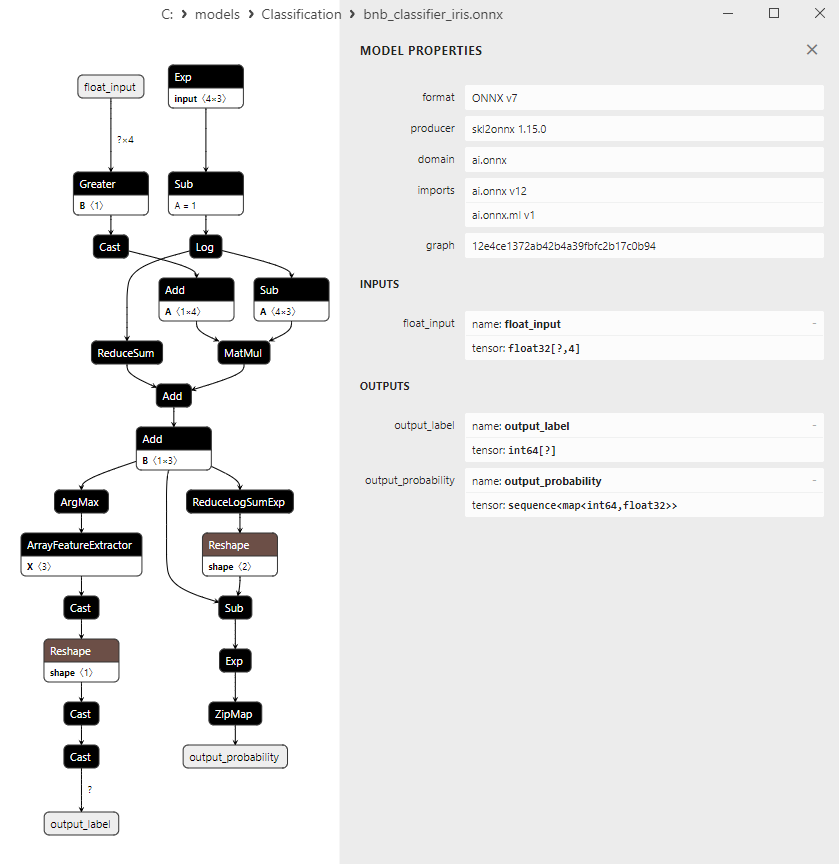

2.21.1. Code de Création du Modèle de Classification Bernoulli Naive Bayes (BNB)

2.21.2. Code MQL5 pour Travailler avec le Modèle de Classification Bernoulli Naive Bayes (BNB)

2.21.3. Représentation ONNX du Modèle de Classification Bernoulli Naive Bayes (BNB) - 2.22. Multilayer Perceptron Classifier

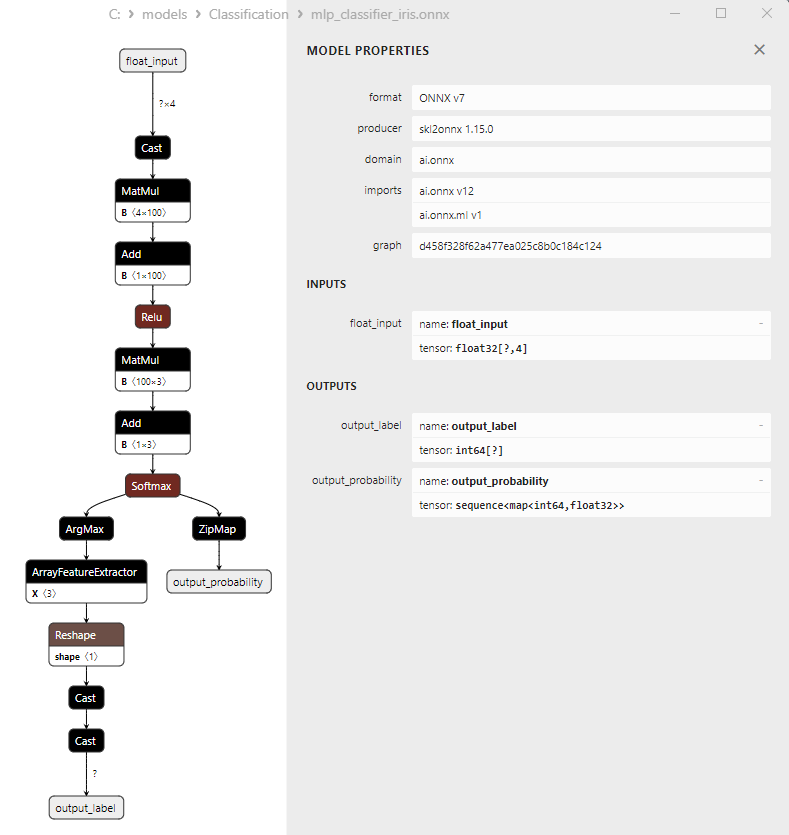

2.22.1. Code pour la Création du Modèle de Classification Multilayer Perceptron

2.22.2. Code MQL5 pour Travailler avec le Modèle de Classification Multilayer Perceptron

2.22.3. Représentation ONNX du Modèle de Classification Multilayer Perceptron - 2.23. Classificateur Linear Discriminant Analysis (LDA)

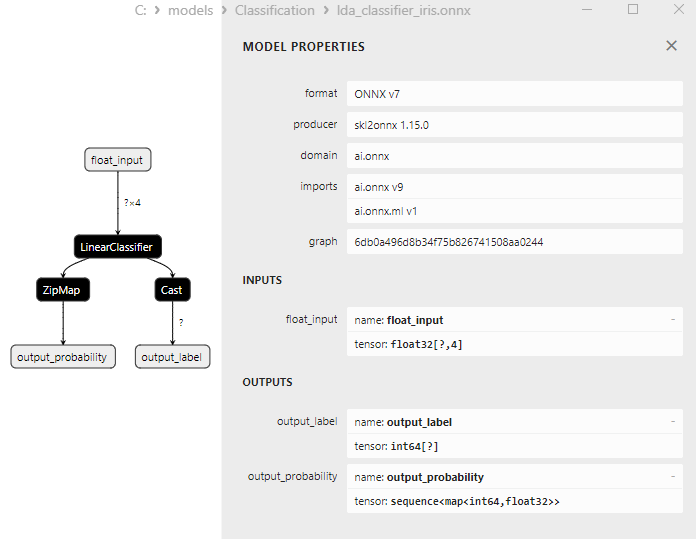

2.23.1. Code de Création du Modèle de Classification Linear Discriminant Analysis (LDA)

2.23.2. Code MQL5 pour Travailler avec le Modèle de Classification Linear Discriminant Analysis (LDA)

2.23.3. Représentation ONNX du Modèle de Classification Linear Discriminant Analysis (LDA) - 2.24. Hist Gradient Boosting

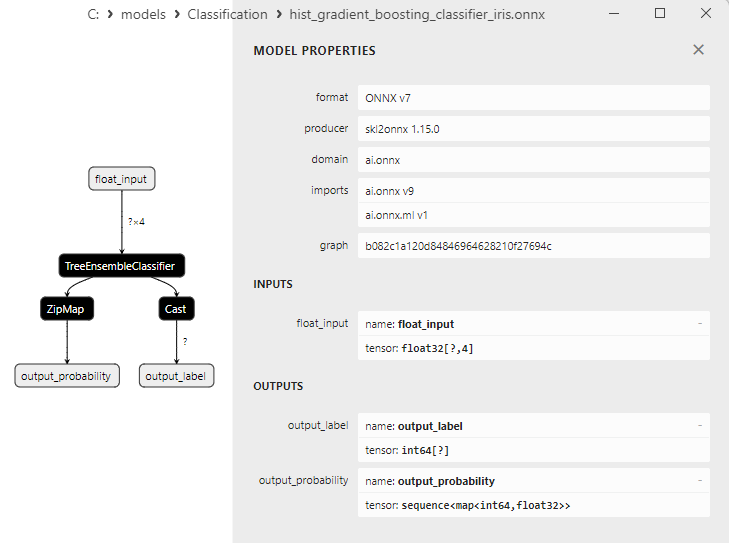

2.24.1. Code pour la Création du Modèle de Classification Histogram-Based Gradient Boosting

2.24.2. Code MQL5 pour Travailler avec le Modèle de Classification Histogram-Based Gradient Boosting

2.24.3. Représentation ONNX du Modèle de Classification Histogram-Based Gradient Boosting - 2.25. Classificateur CategoricalNB

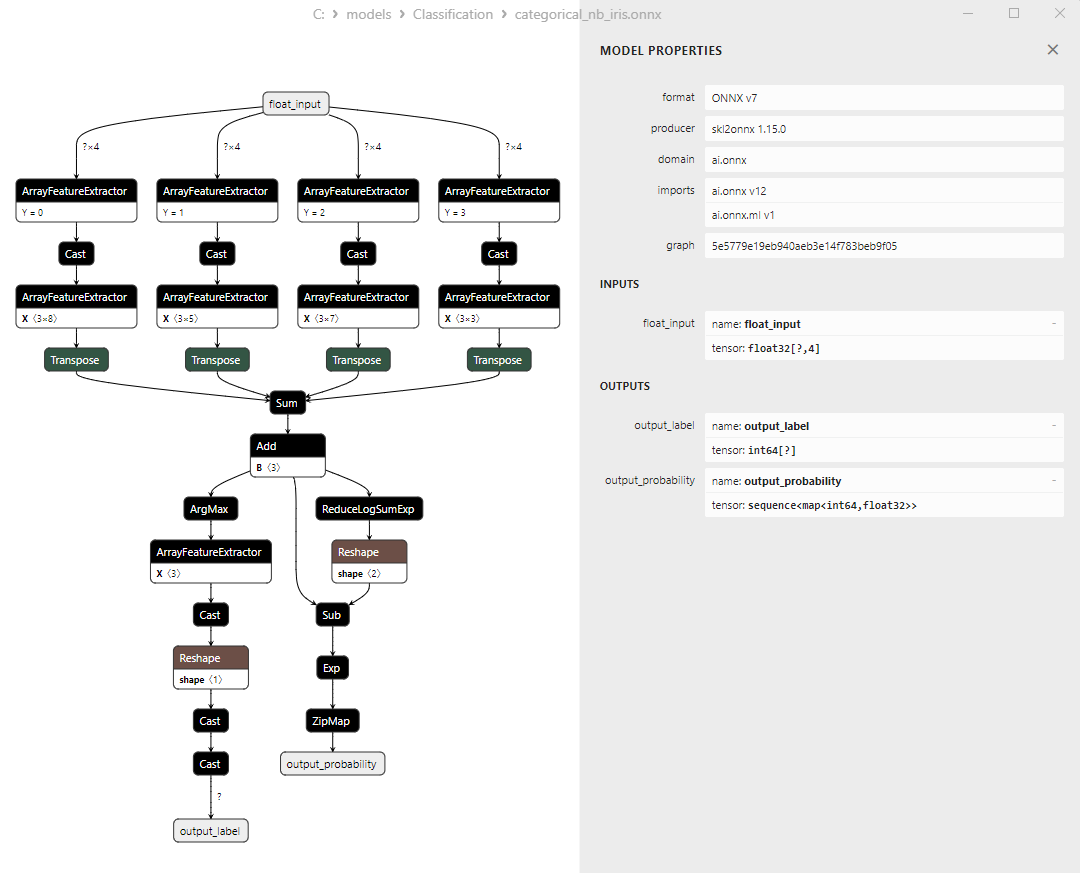

2.25.1. Code pour la Création du Modèle de Classification CategoricalNB

2.25.2. Code MQL5 pour Travailler avec le Modèle de Classification CategoricalNB

2.25.3. Représentation ONNX du Modèle de Classification CategoricalNB - 2.26. ExtraTreeClassifier

2.26.1. Code de Création du Modèle ExtraTreeClassifier

2.26.2. Code MQL5 pour Travailler avec le Modèle ExtraTreeClassifier

2.26.3. Représentation ONNX du Modèle ExtraTreeClassifier - 2.27. ExtraTreesClassifier

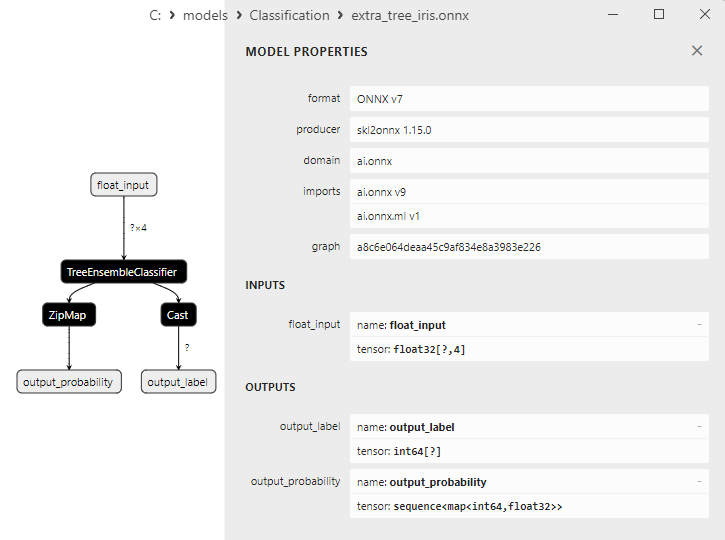

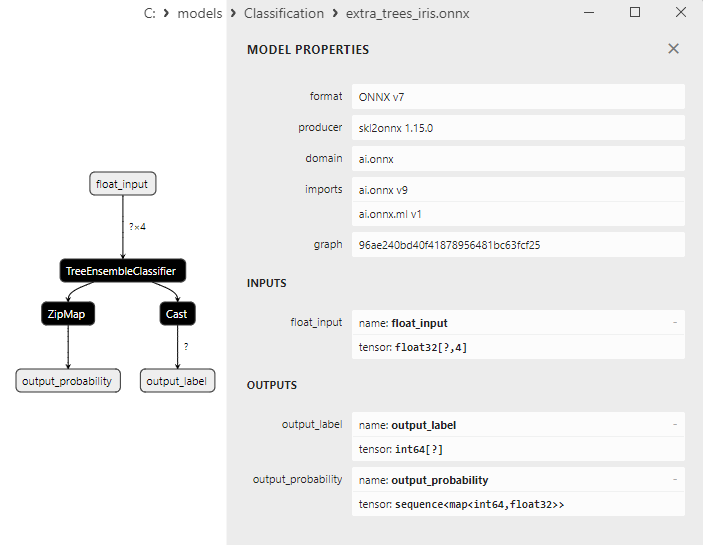

2.27.1. Code de Création du Modèle ExtraTreesClassifier

2.27.2. Code MQL5 pour Travailler avec le Modèle ExtraTreesClassifier

2.27.3. Représentation ONNX du Modèle ExtraTreesClassifier - 2.28. Comparaison de la Précision de Tous les Modèles

2.28.1. Code pour le Calcul de Tous les Modèles et Construire un Tableau de Comparaison de la Précision

2.28.2. Code MQL5 pour l'Exécution de Tous les Modèles ONNX - 2.29. Modèles de Classification Scikit-Learn qui n'ont pas pu être convertis en ONNX

- 2.29.1. DummyClassifier

2.29.1.1. Code de Création du Modèle DummyClassifier - 2.29.2. GaussianProcessClassifier

2.29.2.1. Code de Création du Modèle GaussianProcessClassifier - 2.29.3. Classificateur LabelPropagation

2.29.3.1. Code de Création du Modèle LabelPropagationClassifier - 2.29.4. Classificateur LabelSpreading

2.29.4.1. Code de Création du Modèle LabelSpreadingClassifier - 2.29.5. Classificateur NearestCentroid

2.29.5.1. Code pour la Création du Modèle NearestCentroid - 2.29.6. Classificateur Quadratic Discriminant Analysis

2.29.6.1. Code pour la Création du Modèle Quadratic Discriminant Analysis - Conclusions

1. Iris de Fisher

L'ensemble de données Iris est l'un des ensembles de données les plus connus et les plus utilisés dans le domaine de l'apprentissage automatique. Il a été introduit pour la première fois en 1936 par le statisticien et biologiste R.A. Fisher et est devenu depuis un ensemble de données classique pour les tâches de classification.

L'ensemble de données Iris consiste en des mesures de sépales et de pétales de trois espèces d'iris : Iris setosa, Iris virginica et Iris versicolor.

Figure 1. Iris setosa

Figure 2. Iris virginica

Figure 3. Iris versicolor

L'ensemble de données Iris comprend 150 instances d'iris, avec 50 instances de chacune des trois espèces. Chaque instance a 4 caractéristiques numériques (mesurées en centimètres) :

- Longueur du sépale

- Largeur du sépale

- Longueur du pétale

- Largeur du pétale

Chaque instance a également une classe correspondante indiquant l'espèce d'iris (Iris setosa, Iris virginica ou Iris versicolor). Cette caractéristique de classification fait de l'ensemble de données Iris un ensemble de données idéal pour les tâches d'apprentissage automatique telles que la classification et le regroupement.

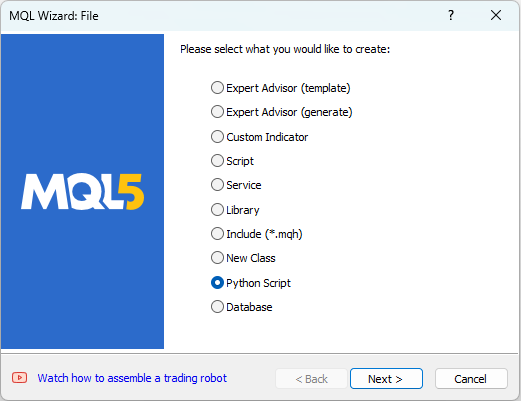

MetaEditor permet de travailler avec des scripts Python. Pour créer un script Python, sélectionnez "Nouveau" dans le menu "Fichier" de MetaEditor, et une boîte de dialogue permettant de choisir l'objet à créer apparaît (voir figure 4).

Figure 4. Création d'un script Python dans l'Assistant MQL5 - Etape 1

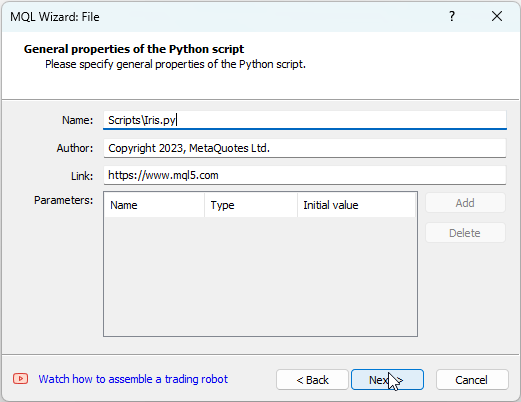

Donnez ensuite un nom au script, par exemple "IRIS.py" (voir figure 5).

Figure 5. Création d'un script Python dans l'Assistant MQL5 - Etape 2 - Nom du script

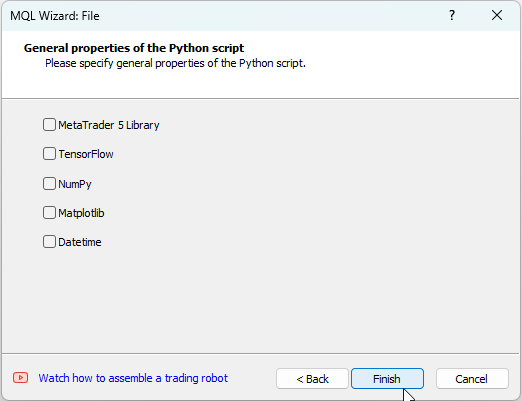

Vous pouvez ensuite spécifier les bibliothèques qui seront utilisées. Dans notre cas, nous laisserons ces champs vides (voir figure 6).

Figure 6 : Création d'un script Python dans l'Assistant MQL5 - Etape 3

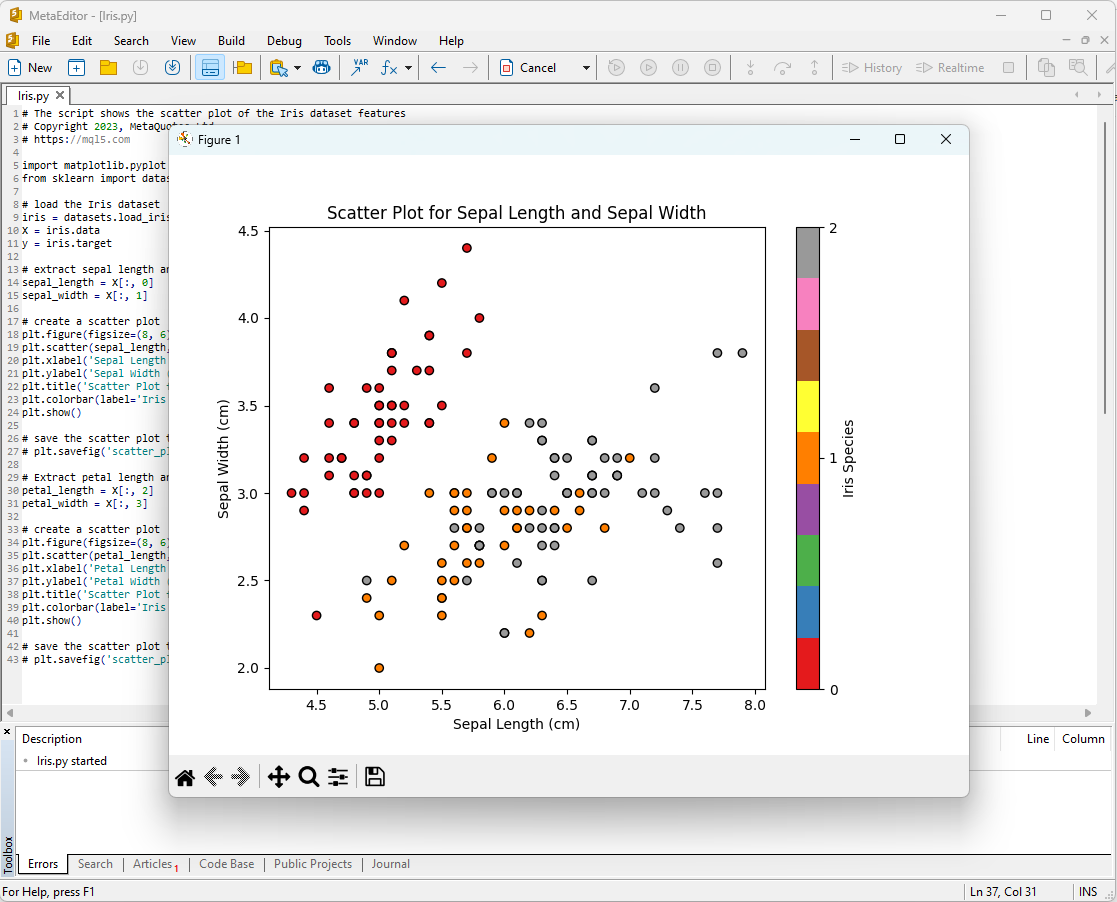

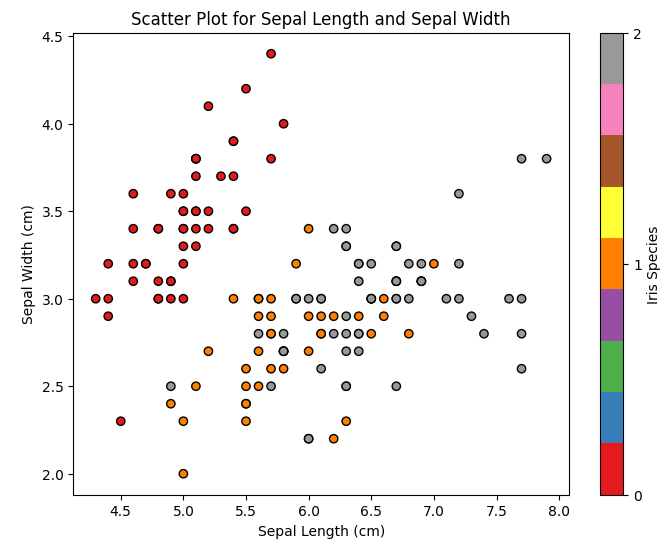

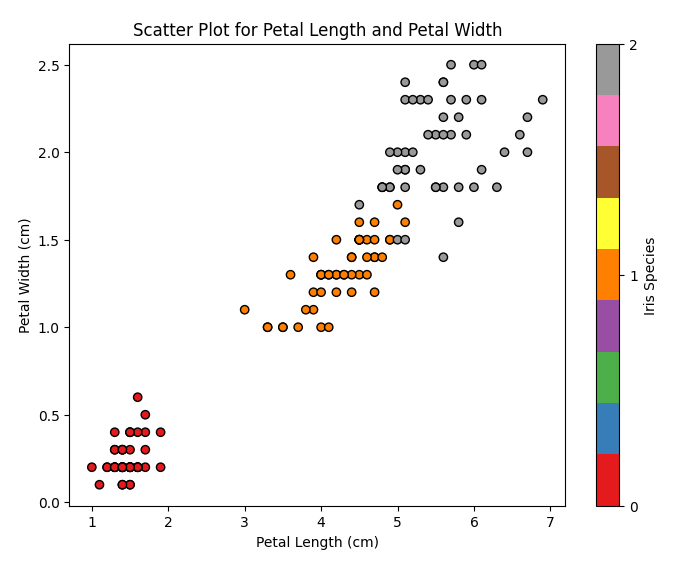

L'une des façons de commencer l'analyse de l'ensemble de données Iris est de visualiser les données. Une représentation graphique nous permet de mieux comprendre la structure des données et les relations entre les caractéristiques.

Par exemple, vous pouvez créer un diagramme de dispersion pour voir comment les différentes espèces d'iris sont réparties dans l'espace des caractéristiques.

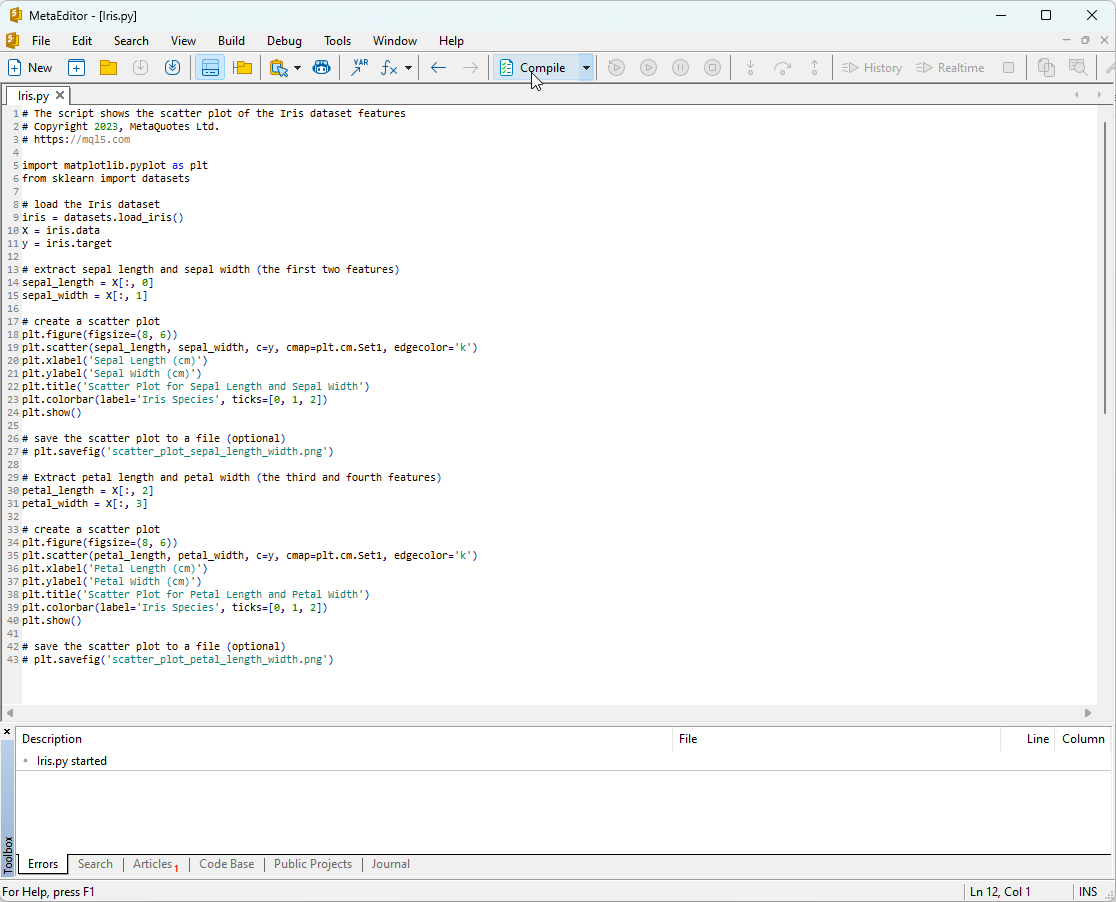

Code du script Python :

# The script shows the scatter plot of the Iris dataset features # Copyright 2023, MetaQuotes Ltd. # https://mql5.com import matplotlib.pyplot as plt from sklearn import datasets # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # extract sepal length and sepal width (the first two features) sepal_length = X[:, 0] sepal_width = X[:, 1] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(sepal_length, sepal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Sepal Length (cm)') plt.ylabel('Sepal Width (cm)') plt.title('Scatter Plot for Sepal Length and Sepal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_sepal_length_width.png') # Extract petal length and petal width (the third and fourth features) petal_length = X[:, 2] petal_width = X[:, 3] # create a scatter plot plt.figure(figsize=(8, 6)) plt.scatter(petal_length, petal_width, c=y, cmap=plt.cm.Set1, edgecolor='k') plt.xlabel('Petal Length (cm)') plt.ylabel('Petal Width (cm)') plt.title('Scatter Plot for Petal Length and Petal Width') plt.colorbar(label='Iris Species', ticks=[0, 1, 2]) plt.show() # save the scatter plot to a file (optional) # plt.savefig('scatter_plot_petal_length_width.png')

Pour exécuter ce script, vous devez le copier dans MetaEditor (voir figure 7) et cliquer sur "Compiler".

Figure 7 : Script IRIS.py dans MetaEditor

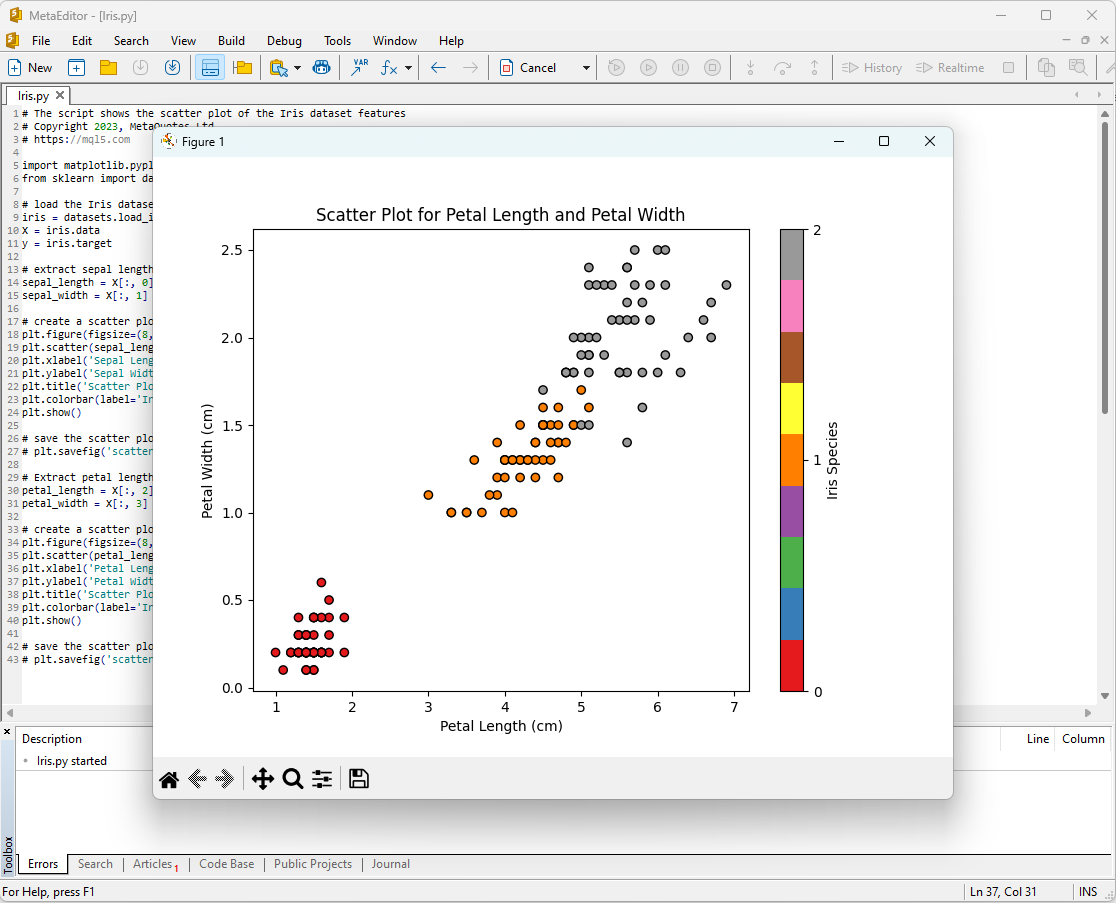

Ensuite, les parcelles s'affichent à l'écran :

Figure 8 : Le script IRIS.py dans MetaEditor avec le tracé de la longueur et de la largeur des sépales

Figure 9 : Le script IRIS.py dans MetaEditor avec le tracé de la longueur et de la largeur des pétales

Examinons-les de plus près.

Figure 10 : Diagramme de dispersion de la longueur du sépale vs la largeur du sépale

Ce graphique montre la répartition des différentes espèces d'iris en fonction de la longueur et de la largeur des sépales. Nous pouvons observer que l'Iris setosa a typiquement des sépales plus courts et plus larges que les deux autres espèces.

Figure 11 : Diagramme de dispersion de la longueur du pétale par rapport à la largeur du pétale

Ce graphique montre la répartition des différentes espèces d'iris en fonction de la longueur et de la largeur des pétales. Nous pouvons remarquer que l'Iris setosa a les pétales les plus courts et les plus étroits, l'Iris virginica a les pétales les plus longs et les plus larges, et l'Iris versicolor se situe entre les deux.

L'ensemble de données Iris est un ensemble de données idéal pour former et tester des modèles d'apprentissage automatique. Nous l'utiliserons pour analyser l'efficacité des modèles d'apprentissage automatique pour une tâche de classification.

2. Modèles de Classification

La classification est l'une des tâches fondamentales de l'apprentissage automatique. Son objectif est de classer les données dans différentes catégories, ou classes, sur la base de certaines caractéristiques.

Explorons les principaux modèles d'apprentissage automatique du paquet scikit-learn.

Liste des Classificateurs Scikit-learn

Pour afficher la liste des classificateurs disponibles dans scikit-learn, vous pouvez utiliser le script suivant :

# ScikitLearnClassifiers.py # The script lists all the classification algorithms available in scikit-learn # Copyright 2023, MetaQuotes Ltd. # https://mql5.com # print Python version from platform import python_version print("The Python version is ", python_version()) # print scikit-learn version import sklearn print('The scikit-learn version is {}.'.format(sklearn.__version__)) # print scikit-learn classifiers from sklearn.utils import all_estimators classifiers = all_estimators(type_filter='classifier') for index, (name, ClassifierClass) in enumerate(classifiers, start=1): print(f"Classifier {index}: {name}")

Sortie :

Python The scikit-learn version is 1.2.2.

Python Classifier 1: AdaBoostClassifier

Python Classifier 2: BaggingClassifier

Python Classifier 3: BernoulliNB

Python Classifier 4: CalibratedClassifierCV

Python Classifier 5: CategoricalNB

Python Classifier 6: ClassifierChain

Python Classifier 7: ComplementNB

Python Classifier 8: DecisionTreeClassifier

Python Classifier 9: DummyClassifier

Python Classifier 10: ExtraTreeClassifier

Python Classifier 11: ExtraTreesClassifier

Python Classifier 12: GaussianNB

Python Classifier 13: GaussianProcessClassifier

Python Classifier 14: GradientBoostingClassifier

Python Classifier 15: HistGradientBoostingClassifier

Python Classifier 16: KNeighborsClassifier

Python Classifier 17: LabelPropagation

Python Classifier 18: LabelSpreading

Python Classifier 19: LinearDiscriminantAnalysis

Python Classifier 20: LinearSVC

Python Classifier 21: LogisticRegression

Python Classifier 22: LogisticRegressionCV

Python Classifier 23: MLPClassifier

Python Classifier 24: MultiOutputClassifier

Python Classifier 25: MultinomialNB

Python Classifier 26: NearestCentroid

Python Classifier 27: NuSVC

Python Classifier 28: OneVsOneClassifier

Python Classifier 29: OneVsRestClassifier

Python Classifier 30: OutputCodeClassifier

Python Classifier 31: PassiveAggressiveClassifier

Python Classifier 32: Perceptron

Python Classifier 33: QuadraticDiscriminantAnalysis

Python Classifier 34: RadiusNeighborsClassifier

Python Classifier 35: RandomForestClassifier

Python Classifier 36: RidgeClassifier

Python Classifier 37: RidgeClassifierCV

Python Classifier 38: SGDClassifier

Python Classifier 39: SVC

Python Classifier 40: StackingClassifier

Python Classifier 41: VotingClassifier

Pour plus de visibilité dans cette liste de classificateurs, ils sont mis en évidence par des couleurs différentes. Les modèles qui nécessitent des classificateurs de base sont surlignés en jaune, les autres modèles peuvent être utilisés indépendamment.

Pour l'avenir, il est intéressant de noter que les modèles colorés en vert ont été exportés avec succès au format ONNX. Les modèles colorés en rouge rencontrent des erreurs lors de la conversion dans la version actuelle de scikit-learn 1.2.2.

Différentes représentations des données de sortie dans les modèles

Il convient de noter que les différents modèles représentent les données de sortie différemment. Il faut donc être attentif lorsque l'on travaille avec des modèles convertis en ONNX.

Pour la tâche de classification de l'Iris de Fisher, les tenseurs d'entrée ont le même format pour tous ces modèles :

1. Nom : float_input, Type de Données : tensor(float), Forme : [None, 4]

Les tenseurs de sortie des modèles ONNX sont différents.

1. Modèles ne nécessitant pas de post-traitement :

- Classificateur SVC

- Classificateur LinearSVC

- NuSVC Classifier

- Classificateur Radius Neighbors

- Classificateur Ridge

- Classificateur Ridge CV

1. Nom : label, Type de Données : tensor(int64), Forme : [None]

2. Name : probabilities, Type de Données : tensor(float), Forme : [None, 3]

Ces modèles renvoient le résultat (numéro de classe) explicitement dans le premier tenseur entier de sortie "label", sans nécessiter de post-traitement.

2. Modèles dont les résultats nécessitent un post-traitement :

- Classification Random Forest

- Classificateur Gradient Boosting

- Classificateur AdaBoost

- Classificateur Bagging

- Classificateur K-NN

- Classificateur Decision Tree

- Classificateur Logistic Regression

- Classificateur Logistic Regression CV

- Classificateur Passif-Agressif

- Classificateur Perceptron

- Classificateur SGD

- Classificateur Gaussian Naive Bayes

- Classificateur Multinomial Naive Bayes

- Classificateur Complement Naive Bayes

- Classificateur Bernoulli Naive Bayes

- Classification Multilayer Perceptron

- Classificateur Linear Discriminant Analysis

- Classificateur Hist Gradient Boosting

- Classificateur Categorical Naive Bayes

- Classificateur ExtraTree

- Classificateur ExtraTrees

1. Nom : output_label, Type de Données : tensor(int64), Forme : [None]

2. Nom : output_probability, Type de Données : seq(map(int64,tensor(float))), Forme : []

Ces modèles renvoient une liste de classes et de probabilités d'appartenance à chaque classe.

Pour obtenir le résultat dans ces cas, un post-traitement est nécessaire, tel que seq(map(int64, tensor(float)) (recherche de l'élément ayant la probabilité la plus élevée).

Il est donc essentiel d'être attentif et de prendre en compte ces aspects lorsque l'on travaille avec des modèles ONNX. Un exemple de traitement différent des résultats est présenté dans le script au point 2.28.2.

iris.mqh

Pour tester les modèles sur l'ensemble des données Iris dans MQL5, une préparation des données est nécessaire. Pour cela, la fonction PrepareIrisDataset() sera utilisée.

Il est pratique de déplacer ces fonctions dans le fichier iris.mqh.

//+------------------------------------------------------------------+ //| Iris.mqh | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" //+------------------------------------------------------------------+ //| Structure for the IRIS Dataset sample | //+------------------------------------------------------------------+ struct sIRISsample { int sample_id; // sample id (1-150) double features[4]; // SepalLengthCm,SepalWidthCm,PetalLengthCm,PetalWidthCm string class_name; // class ("Iris-setosa","Iris-versicolor","Iris-virginica") int class_id; // class id (0,1,2), calculated by function IRISClassID }; //--- Iris dataset sIRISsample ExtIRISDataset[]; int Exttotal=0; //+------------------------------------------------------------------+ //| Returns class id by class name | //+------------------------------------------------------------------+ int IRISClassID(string class_name) { //--- if(class_name=="Iris-setosa") return(0); else if(class_name=="Iris-versicolor") return(1); else if(class_name=="Iris-virginica") return(2); //--- return(-1); } //+------------------------------------------------------------------+ //| AddSample | //+------------------------------------------------------------------+ bool AddSample(const int Id,const double SepalLengthCm,const double SepalWidthCm,const double PetalLengthCm,const double PetalWidthCm, const string Species) { //--- ExtIRISDataset[Exttotal].sample_id=Id; //--- ExtIRISDataset[Exttotal].features[0]=SepalLengthCm; ExtIRISDataset[Exttotal].features[1]=SepalWidthCm; ExtIRISDataset[Exttotal].features[2]=PetalLengthCm; ExtIRISDataset[Exttotal].features[3]=PetalWidthCm; //--- ExtIRISDataset[Exttotal].class_name=Species; ExtIRISDataset[Exttotal].class_id=IRISClassID(Species); //--- Exttotal++; //--- return(true); } //+------------------------------------------------------------------+ //| Prepare Iris Dataset | //+------------------------------------------------------------------+ bool PrepareIrisDataset(sIRISsample &iris_samples[]) { ArrayResize(ExtIRISDataset,150); Exttotal=0; //--- AddSample(1,5.1,3.5,1.4,0.2,"Iris-setosa"); AddSample(2,4.9,3.0,1.4,0.2,"Iris-setosa"); AddSample(3,4.7,3.2,1.3,0.2,"Iris-setosa"); AddSample(4,4.6,3.1,1.5,0.2,"Iris-setosa"); AddSample(5,5.0,3.6,1.4,0.2,"Iris-setosa"); AddSample(6,5.4,3.9,1.7,0.4,"Iris-setosa"); AddSample(7,4.6,3.4,1.4,0.3,"Iris-setosa"); AddSample(8,5.0,3.4,1.5,0.2,"Iris-setosa"); AddSample(9,4.4,2.9,1.4,0.2,"Iris-setosa"); AddSample(10,4.9,3.1,1.5,0.1,"Iris-setosa"); AddSample(11,5.4,3.7,1.5,0.2,"Iris-setosa"); AddSample(12,4.8,3.4,1.6,0.2,"Iris-setosa"); AddSample(13,4.8,3.0,1.4,0.1,"Iris-setosa"); AddSample(14,4.3,3.0,1.1,0.1,"Iris-setosa"); AddSample(15,5.8,4.0,1.2,0.2,"Iris-setosa"); AddSample(16,5.7,4.4,1.5,0.4,"Iris-setosa"); AddSample(17,5.4,3.9,1.3,0.4,"Iris-setosa"); AddSample(18,5.1,3.5,1.4,0.3,"Iris-setosa"); AddSample(19,5.7,3.8,1.7,0.3,"Iris-setosa"); AddSample(20,5.1,3.8,1.5,0.3,"Iris-setosa"); AddSample(21,5.4,3.4,1.7,0.2,"Iris-setosa"); AddSample(22,5.1,3.7,1.5,0.4,"Iris-setosa"); AddSample(23,4.6,3.6,1.0,0.2,"Iris-setosa"); AddSample(24,5.1,3.3,1.7,0.5,"Iris-setosa"); AddSample(25,4.8,3.4,1.9,0.2,"Iris-setosa"); AddSample(26,5.0,3.0,1.6,0.2,"Iris-setosa"); AddSample(27,5.0,3.4,1.6,0.4,"Iris-setosa"); AddSample(28,5.2,3.5,1.5,0.2,"Iris-setosa"); AddSample(29,5.2,3.4,1.4,0.2,"Iris-setosa"); AddSample(30,4.7,3.2,1.6,0.2,"Iris-setosa"); AddSample(31,4.8,3.1,1.6,0.2,"Iris-setosa"); AddSample(32,5.4,3.4,1.5,0.4,"Iris-setosa"); AddSample(33,5.2,4.1,1.5,0.1,"Iris-setosa"); AddSample(34,5.5,4.2,1.4,0.2,"Iris-setosa"); AddSample(35,4.9,3.1,1.5,0.2,"Iris-setosa"); AddSample(36,5.0,3.2,1.2,0.2,"Iris-setosa"); AddSample(37,5.5,3.5,1.3,0.2,"Iris-setosa"); AddSample(38,4.9,3.6,1.4,0.1,"Iris-setosa"); AddSample(39,4.4,3.0,1.3,0.2,"Iris-setosa"); AddSample(40,5.1,3.4,1.5,0.2,"Iris-setosa"); AddSample(41,5.0,3.5,1.3,0.3,"Iris-setosa"); AddSample(42,4.5,2.3,1.3,0.3,"Iris-setosa"); AddSample(43,4.4,3.2,1.3,0.2,"Iris-setosa"); AddSample(44,5.0,3.5,1.6,0.6,"Iris-setosa"); AddSample(45,5.1,3.8,1.9,0.4,"Iris-setosa"); AddSample(46,4.8,3.0,1.4,0.3,"Iris-setosa"); AddSample(47,5.1,3.8,1.6,0.2,"Iris-setosa"); AddSample(48,4.6,3.2,1.4,0.2,"Iris-setosa"); AddSample(49,5.3,3.7,1.5,0.2,"Iris-setosa"); AddSample(50,5.0,3.3,1.4,0.2,"Iris-setosa"); AddSample(51,7.0,3.2,4.7,1.4,"Iris-versicolor"); AddSample(52,6.4,3.2,4.5,1.5,"Iris-versicolor"); AddSample(53,6.9,3.1,4.9,1.5,"Iris-versicolor"); AddSample(54,5.5,2.3,4.0,1.3,"Iris-versicolor"); AddSample(55,6.5,2.8,4.6,1.5,"Iris-versicolor"); AddSample(56,5.7,2.8,4.5,1.3,"Iris-versicolor"); AddSample(57,6.3,3.3,4.7,1.6,"Iris-versicolor"); AddSample(58,4.9,2.4,3.3,1.0,"Iris-versicolor"); AddSample(59,6.6,2.9,4.6,1.3,"Iris-versicolor"); AddSample(60,5.2,2.7,3.9,1.4,"Iris-versicolor"); AddSample(61,5.0,2.0,3.5,1.0,"Iris-versicolor"); AddSample(62,5.9,3.0,4.2,1.5,"Iris-versicolor"); AddSample(63,6.0,2.2,4.0,1.0,"Iris-versicolor"); AddSample(64,6.1,2.9,4.7,1.4,"Iris-versicolor"); AddSample(65,5.6,2.9,3.6,1.3,"Iris-versicolor"); AddSample(66,6.7,3.1,4.4,1.4,"Iris-versicolor"); AddSample(67,5.6,3.0,4.5,1.5,"Iris-versicolor"); AddSample(68,5.8,2.7,4.1,1.0,"Iris-versicolor"); AddSample(69,6.2,2.2,4.5,1.5,"Iris-versicolor"); AddSample(70,5.6,2.5,3.9,1.1,"Iris-versicolor"); AddSample(71,5.9,3.2,4.8,1.8,"Iris-versicolor"); AddSample(72,6.1,2.8,4.0,1.3,"Iris-versicolor"); AddSample(73,6.3,2.5,4.9,1.5,"Iris-versicolor"); AddSample(74,6.1,2.8,4.7,1.2,"Iris-versicolor"); AddSample(75,6.4,2.9,4.3,1.3,"Iris-versicolor"); AddSample(76,6.6,3.0,4.4,1.4,"Iris-versicolor"); AddSample(77,6.8,2.8,4.8,1.4,"Iris-versicolor"); AddSample(78,6.7,3.0,5.0,1.7,"Iris-versicolor"); AddSample(79,6.0,2.9,4.5,1.5,"Iris-versicolor"); AddSample(80,5.7,2.6,3.5,1.0,"Iris-versicolor"); AddSample(81,5.5,2.4,3.8,1.1,"Iris-versicolor"); AddSample(82,5.5,2.4,3.7,1.0,"Iris-versicolor"); AddSample(83,5.8,2.7,3.9,1.2,"Iris-versicolor"); AddSample(84,6.0,2.7,5.1,1.6,"Iris-versicolor"); AddSample(85,5.4,3.0,4.5,1.5,"Iris-versicolor"); AddSample(86,6.0,3.4,4.5,1.6,"Iris-versicolor"); AddSample(87,6.7,3.1,4.7,1.5,"Iris-versicolor"); AddSample(88,6.3,2.3,4.4,1.3,"Iris-versicolor"); AddSample(89,5.6,3.0,4.1,1.3,"Iris-versicolor"); AddSample(90,5.5,2.5,4.0,1.3,"Iris-versicolor"); AddSample(91,5.5,2.6,4.4,1.2,"Iris-versicolor"); AddSample(92,6.1,3.0,4.6,1.4,"Iris-versicolor"); AddSample(93,5.8,2.6,4.0,1.2,"Iris-versicolor"); AddSample(94,5.0,2.3,3.3,1.0,"Iris-versicolor"); AddSample(95,5.6,2.7,4.2,1.3,"Iris-versicolor"); AddSample(96,5.7,3.0,4.2,1.2,"Iris-versicolor"); AddSample(97,5.7,2.9,4.2,1.3,"Iris-versicolor"); AddSample(98,6.2,2.9,4.3,1.3,"Iris-versicolor"); AddSample(99,5.1,2.5,3.0,1.1,"Iris-versicolor"); AddSample(100,5.7,2.8,4.1,1.3,"Iris-versicolor"); AddSample(101,6.3,3.3,6.0,2.5,"Iris-virginica"); AddSample(102,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(103,7.1,3.0,5.9,2.1,"Iris-virginica"); AddSample(104,6.3,2.9,5.6,1.8,"Iris-virginica"); AddSample(105,6.5,3.0,5.8,2.2,"Iris-virginica"); AddSample(106,7.6,3.0,6.6,2.1,"Iris-virginica"); AddSample(107,4.9,2.5,4.5,1.7,"Iris-virginica"); AddSample(108,7.3,2.9,6.3,1.8,"Iris-virginica"); AddSample(109,6.7,2.5,5.8,1.8,"Iris-virginica"); AddSample(110,7.2,3.6,6.1,2.5,"Iris-virginica"); AddSample(111,6.5,3.2,5.1,2.0,"Iris-virginica"); AddSample(112,6.4,2.7,5.3,1.9,"Iris-virginica"); AddSample(113,6.8,3.0,5.5,2.1,"Iris-virginica"); AddSample(114,5.7,2.5,5.0,2.0,"Iris-virginica"); AddSample(115,5.8,2.8,5.1,2.4,"Iris-virginica"); AddSample(116,6.4,3.2,5.3,2.3,"Iris-virginica"); AddSample(117,6.5,3.0,5.5,1.8,"Iris-virginica"); AddSample(118,7.7,3.8,6.7,2.2,"Iris-virginica"); AddSample(119,7.7,2.6,6.9,2.3,"Iris-virginica"); AddSample(120,6.0,2.2,5.0,1.5,"Iris-virginica"); AddSample(121,6.9,3.2,5.7,2.3,"Iris-virginica"); AddSample(122,5.6,2.8,4.9,2.0,"Iris-virginica"); AddSample(123,7.7,2.8,6.7,2.0,"Iris-virginica"); AddSample(124,6.3,2.7,4.9,1.8,"Iris-virginica"); AddSample(125,6.7,3.3,5.7,2.1,"Iris-virginica"); AddSample(126,7.2,3.2,6.0,1.8,"Iris-virginica"); AddSample(127,6.2,2.8,4.8,1.8,"Iris-virginica"); AddSample(128,6.1,3.0,4.9,1.8,"Iris-virginica"); AddSample(129,6.4,2.8,5.6,2.1,"Iris-virginica"); AddSample(130,7.2,3.0,5.8,1.6,"Iris-virginica"); AddSample(131,7.4,2.8,6.1,1.9,"Iris-virginica"); AddSample(132,7.9,3.8,6.4,2.0,"Iris-virginica"); AddSample(133,6.4,2.8,5.6,2.2,"Iris-virginica"); AddSample(134,6.3,2.8,5.1,1.5,"Iris-virginica"); AddSample(135,6.1,2.6,5.6,1.4,"Iris-virginica"); AddSample(136,7.7,3.0,6.1,2.3,"Iris-virginica"); AddSample(137,6.3,3.4,5.6,2.4,"Iris-virginica"); AddSample(138,6.4,3.1,5.5,1.8,"Iris-virginica"); AddSample(139,6.0,3.0,4.8,1.8,"Iris-virginica"); AddSample(140,6.9,3.1,5.4,2.1,"Iris-virginica"); AddSample(141,6.7,3.1,5.6,2.4,"Iris-virginica"); AddSample(142,6.9,3.1,5.1,2.3,"Iris-virginica"); AddSample(143,5.8,2.7,5.1,1.9,"Iris-virginica"); AddSample(144,6.8,3.2,5.9,2.3,"Iris-virginica"); AddSample(145,6.7,3.3,5.7,2.5,"Iris-virginica"); AddSample(146,6.7,3.0,5.2,2.3,"Iris-virginica"); AddSample(147,6.3,2.5,5.0,1.9,"Iris-virginica"); AddSample(148,6.5,3.0,5.2,2.0,"Iris-virginica"); AddSample(149,6.2,3.4,5.4,2.3,"Iris-virginica"); AddSample(150,5.9,3.0,5.1,1.8,"Iris-virginica"); //--- ArrayResize(iris_samples,150); for(int i=0; i<Exttotal; i++) { iris_samples[i]=ExtIRISDataset[i]; } //--- return(true); } //+------------------------------------------------------------------+

Comparons 3 méthodes de classification courantes : SVC (Support Vector Classification), LinearSVC (Linear Support Vector Classification) et NuSVC (Nu Support Vector Classification).

Principes de Fonctionnement :

SVC (Support Vector Classification)

Principe de Fonctionnement : Le SVC est une méthode de classification basée sur la maximisation de la marge entre les classes. Il recherche un hyperplan de séparation optimal qui sépare au maximum les classes et soutient les vecteurs de soutien - les points les plus proches de l'hyperplan.

Fonctions Noyau : Le SVC peut utiliser différentes fonctions noyau, telles que la fonction linéaire, la fonction de base radiale (RBF), la fonction polynomiale et d'autres encore. La fonction noyau détermine comment les données sont transformées pour trouver l'hyperplan optimal.

LinearSVC (Linear Support Vector Classification)

Principe de Fonctionnement : LinearSVC est une variante de SVC spécialisée dans la classification linéaire. Elle recherche un hyperplan de séparation linéaire optimal sans utiliser de fonctions noyau. Elle est donc plus rapide et plus efficace lorsqu'il s'agit de travailler avec de grands volumes de données.

NuSVC (Nu Support Vector Classification)

Principe de Fonctionnement : NuSVC est également basé sur les méthodes de vecteurs de support mais introduit un paramètre Nu (nu), qui contrôle la complexité du modèle et la fraction des vecteurs de support. La valeur Nu est comprise entre 0 et 1 et détermine la part des données qui peut être utilisée pour les vecteurs de support et pour les erreurs.

Avantages :

SVC

Algorithme Puissant : Le SVC peut gérer des tâches de classification complexes et travailler avec des données non linéaires grâce à l'utilisation de fonctions noyau.

Robustesse face aux valeurs aberrantes : Le SVC est résistant aux données aberrantes car il utilise des vecteurs de support pour construire l'hyperplan de séparation.

LinearSVC

Haute Efficacité : LinearSVC est plus rapide et plus efficace lorsqu'il s'agit de traiter de grands ensembles de données, en particulier lorsque les données sont volumineuses et que la séparation linéaire est adaptée à la tâche.

Classification Linéaire : Si le problème est bien linéairement séparable, LinearSVC peut donner de bons résultats sans qu'il soit nécessaire d'utiliser des fonctions noyau complexes.

NuSVC

Contrôle de la Complexité des Modèles : Le paramètre Nu de NuSVC vous permet de contrôler la complexité du modèle et le compromis entre l'adaptation aux données et la généralisation.

Robustesse face aux valeurs aberrantes : Comme le SVC, le NuSVC est résistant aux valeurs aberrantes, ce qui le rend utile pour les tâches impliquant des données bruyantes.

Limites :

SVC

Complexité de Calcul : Le SVC peut être lent sur de grands ensembles de données et/ou lors de l'utilisation de fonctions de noyau complexes.

Sensibilité du Noyau : Le choix de la bonne fonction noyau peut être une tâche difficile et avoir un impact significatif sur la performance du modèle.

LinearSVC

Contrainte de Linéarité : LinearSVC est limité par la séparation linéaire des données et peut donner de mauvais résultats dans les cas de dépendances non linéaires entre les caractéristiques et la variable cible.

NuSVC

Réglage du Paramètre Nu : Le réglage du paramètre Nu peut nécessiter du temps et des tests pour obtenir des résultats optimaux.

En fonction des caractéristiques de la tâche et du volume de données, chacune de ces méthodes peut constituer le meilleur choix. Il est important de mener des expériences et de sélectionner la méthode qui répond le mieux aux exigences spécifiques de la tâche de classification.

2.1. Classificateur SVC

La méthode de classification Support Vector Classification (SVC) est un puissant algorithme d'apprentissage automatique largement utilisé pour résoudre les tâches de classification.

Principes de Fonctionnement :

- Hyper-plan de Séparation Optimal

Principe de Fonctionnement : L'idée principale du SVC est de trouver l'hyper-plan de séparation optimal dans l'espace des caractéristiques. Cet hyper-plan doit maximiser la séparation entre les objets de différentes classes et soutenir les vecteurs de soutien, qui sont les points de données les plus proches de l'hyper-plan.

Maximiser la Marge : Le SVC vise à maximiser la marge entre les classes, c'est-à-dire la distance entre les vecteurs de support et l'hyper-plan. Cela permet à la méthode d'être résistante aux valeurs aberrantes et de bien s'adapter à de nouvelles données. - Utilisation des Fonctions Noyau

Fonctions Noyau : Le SVC peut utiliser différentes fonctions noyau, telles que la fonction linéaire, la fonction de base radiale (RBF), la fonction polynomiale et d'autres encore. La fonction noyau permet de projeter les données dans un espace de dimension supérieure où la tâche devient linéaire, même s'il n'y a pas de séparabilité linéaire dans l'espace de données d'origine.

Sélection du Noyau : Le choix de la bonne fonction noyau peut avoir un impact significatif sur les performances du modèle SVC. Un hyper-plan linéaire n'est pas toujours la solution optimale.

Avantages :

- Algorithme Puissant. Gérer des Tâches Complexes : Le SVC peut résoudre des tâches de classification complexes, y compris celles qui présentent des dépendances non linéaires entre les caractéristiques et la variable cible.

- Robustesse face aux valeurs aberrantes : L'utilisation de vecteurs de support rend la méthode robuste aux données aberrantes. Elle dépend des vecteurs de support plutôt que de l'ensemble des données.

- Flexibilité du Noyau. Adaptabilité aux Données : La possibilité d'utiliser différentes fonctions noyau permet à SVC de s'adapter à des données spécifiques et de découvrir des relations non linéaires.

- Bonne Généralisation. Généralisation à de Nouvelles Données : Le modèle SVC peut se généraliser à de nouvelles données, ce qui le rend utile pour les tâches de prédiction.

Limites :

- Complexité de Calcul. Durée de la Formation : L'apprentissage du SVC peut être lent, en particulier lorsqu'il s'agit de grands volumes de données ou de fonctions noyau complexes.

- Sélection du Noyau. Choisir la Bonne Fonction Noyau : La sélection de la bonne fonction noyau peut nécessiter des tests et dépend des caractéristiques des données.

- Sensibilité à la Mise à l'Echelle des Caractéristiques. Normalisation des Données : Le SVC est sensible à la mise à l'échelle des caractéristiques, il est donc recommandé de normaliser ou de standardiser les données avant l'entraînement.

- Interprétabilité du Modèle. Complexité d'Interprétation : Les modèles SVC peuvent être complexes à interpréter en raison de l'utilisation de noyaux non linéaires et d'une multitude de vecteurs de support.

En fonction de la tâche spécifique et du volume de données, la méthode SVC peut être un outil puissant pour résoudre les tâches de classification. Mais il est essentiel de tenir compte de ses limites et de régler les paramètres pour obtenir des résultats optimaux.

2.1.1. Code de Création du Modèle de Classification SVC

Ce code démontre le processus d'entraînement d'un modèle de Classificateur SVC sur le jeu de données Iris, son export au format ONNX et la réalisation d'une classification à l'aide du modèle ONNX. Il évalue également la précision du modèle original et du modèle ONNX.

# Iris_SVCClassifier.py # The code demonstrates the process of training SVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import SVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create an SVC Classifier model with a linear kernel svc_model = SVC(kernel='linear', C=1.0) # train the model on the entire dataset svc_model.fit(X, y) # predict classes for the entire dataset y_pred = svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of SVC Classifier model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path +"svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of SVC Classifier model in ONNX format:", accuracy_onnx)

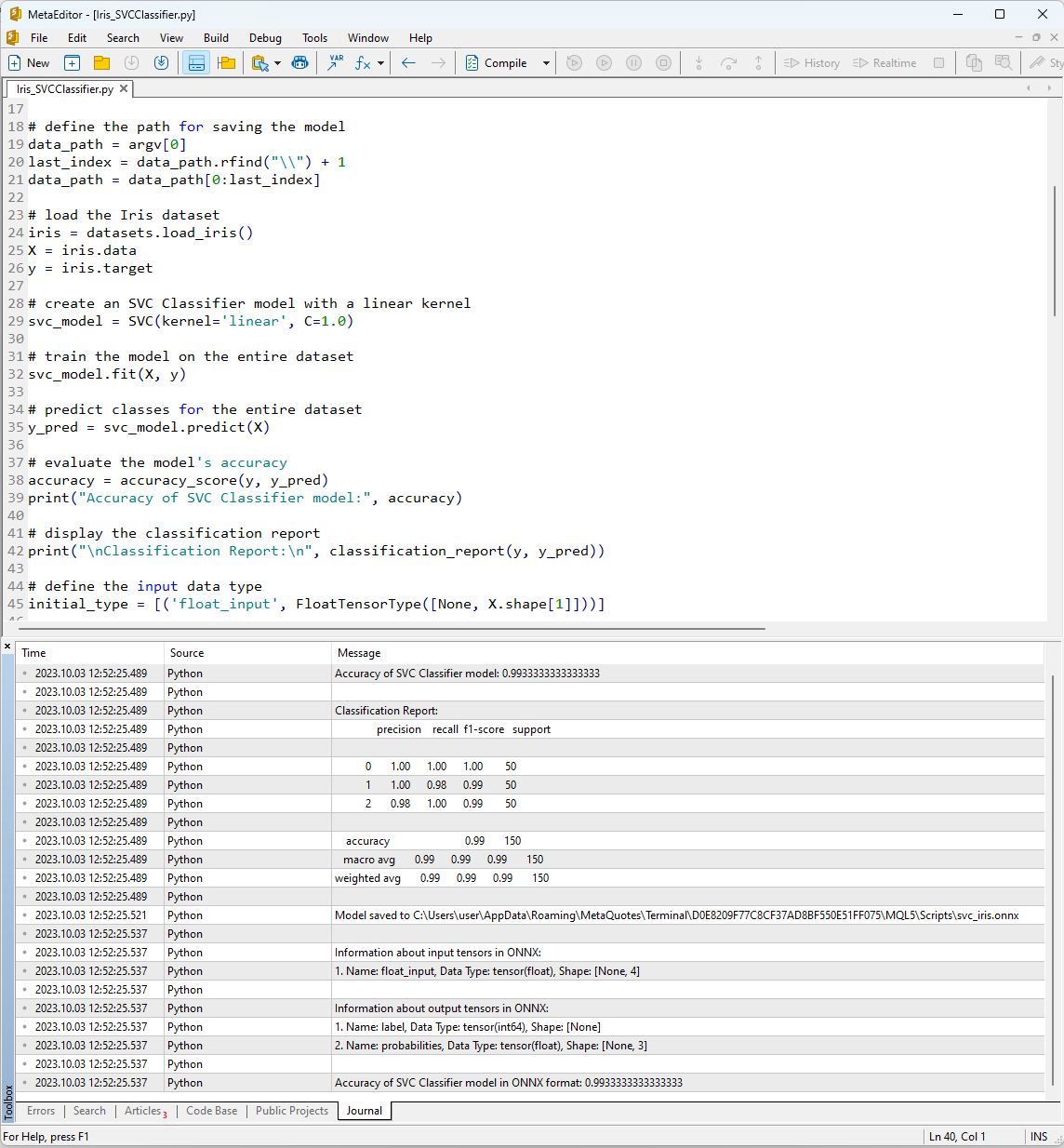

Après avoir exécuté le script dans MetaEditor en utilisant le bouton "Compiler", vous pouvez voir les résultats de son exécution dans l'onglet Journal.

Figure 12. Résultats du script Iris_SVMClassifier.py dans MetaEditor

Sortie du script Iris_SVCClassifier.py :

Python Accuracy of SVC Classifier model: 0.9933333333333333

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 1.00 0.98 0.99 50

Python 2 0.98 1.00 0.99 50

Python

Python accuracy 0.99 150

Python macro avg 0.99 0.99 0.99 150

Python weighted avg 0.99 0.99 0.99 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\svc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of SVC Classifier model in ONNX format: 0.9933333333333333

Vous trouverez ici des informations sur le chemin où le modèle ONNX a été sauvegardé, les types de paramètres d'entrée et de sortie du modèle ONNX, ainsi que la précision dans la description de l'ensemble de données Iris.

La précision de la description de l'ensemble de données à l'aide du Classificateur SVM est de 99 %, et le modèle exporté au format ONNX présente le même niveau de précision.

Nous allons maintenant vérifier ces résultats dans MQL5 en exécutant le modèle construit pour chacun des 150 échantillons de données. Le script comprend également un exemple de traitement des données par lots.

2.1.2. Code MQL5 pour travailler avec le modèle de Classification SVC

//+------------------------------------------------------------------+ //| Iris_SVCClassifier.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="SVCClassifier"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

Les résultats de l'exécution du script sont affichés dans l'onglet "Experts" du terminal MetaTrader 5.

Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_SVCClassifier (EURUSD,H1) model:SVCClassifier correct results: 99.33% Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier all samples accuracy=0.993333 Iris_SVCClassifier (EURUSD,H1) model=SVCClassifier batch test accuracy=1.000000

Le modèle SVC a correctement classé 149 échantillons sur 150, ce qui est un excellent résultat. Le modèle n'a commis qu'une seule erreur de classification dans l'ensemble de données Iris, en prédisant la classe 2 (versicolor) au lieu de la classe 1 (virginica) pour l'échantillon n° 84.

Il est intéressant de noter que la précision du modèle ONNX exporté sur l'ensemble du jeu de données Iris est de 99,33 %, ce qui correspond à la précision du modèle original.

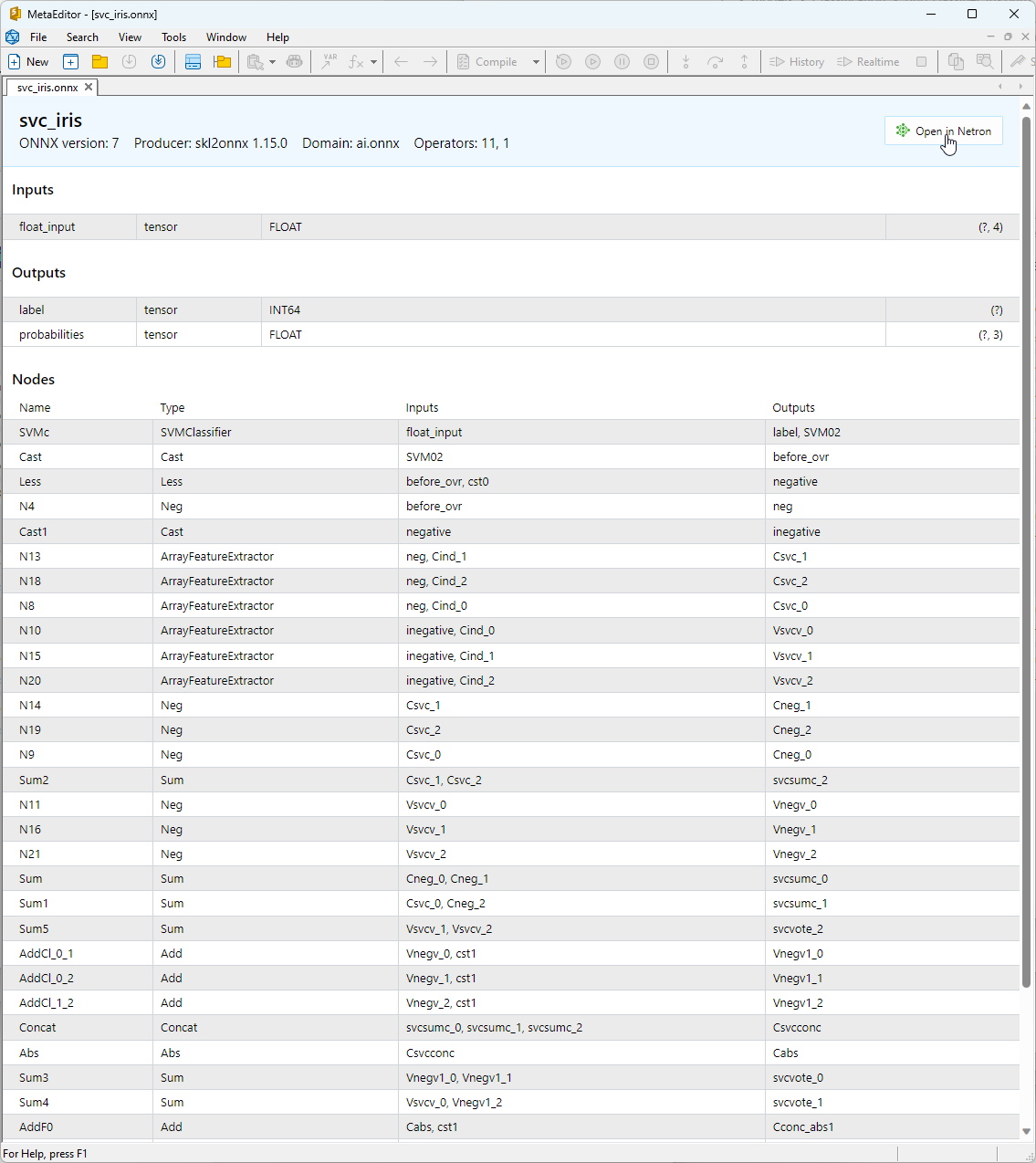

2.1.3. Représentation ONNX du Modèle de Classification SVC

Vous pouvez visualiser le modèle ONNX construit dans MetaEditor.

Figure 13. Modèle ONNX svc_iris.onnx dans MetaEditor

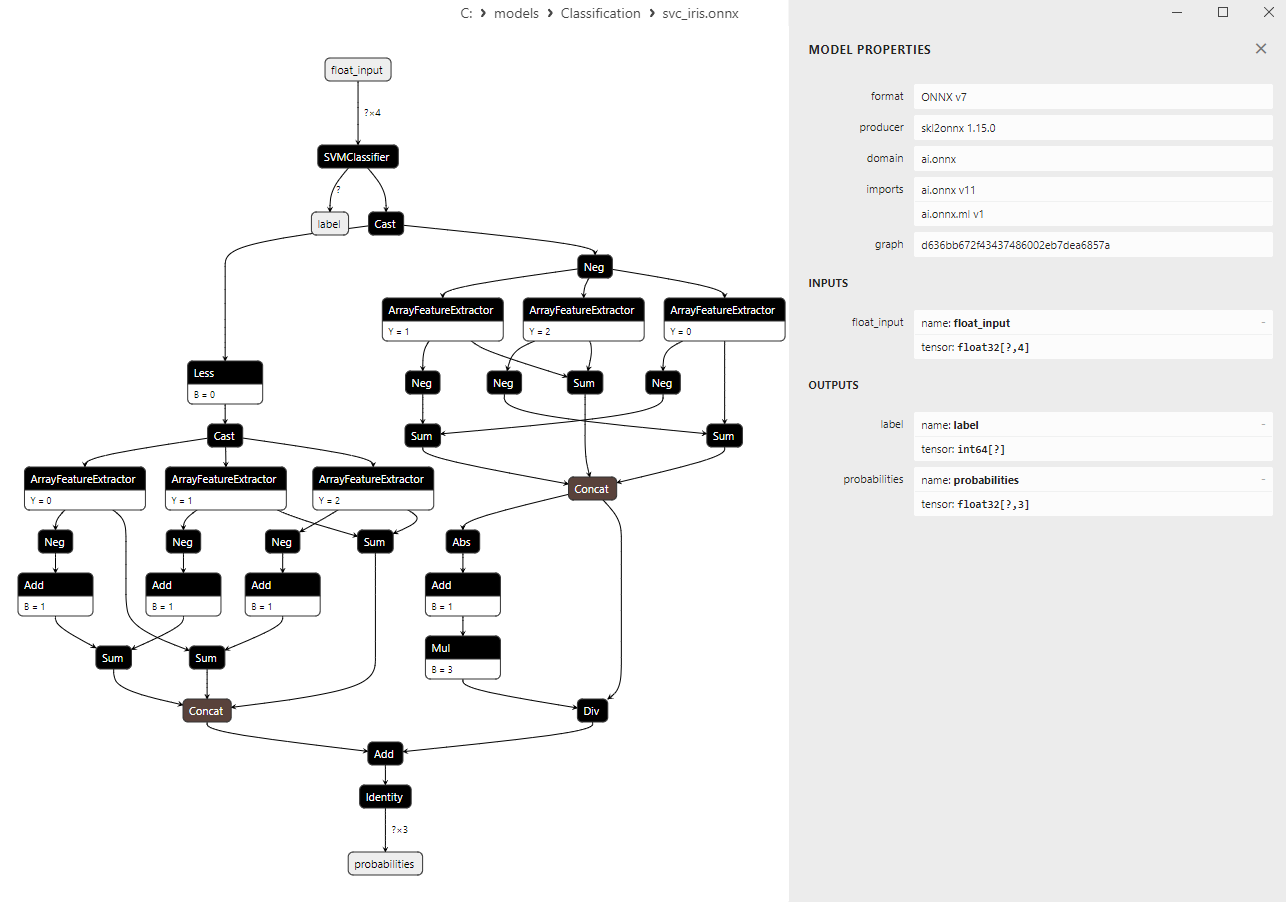

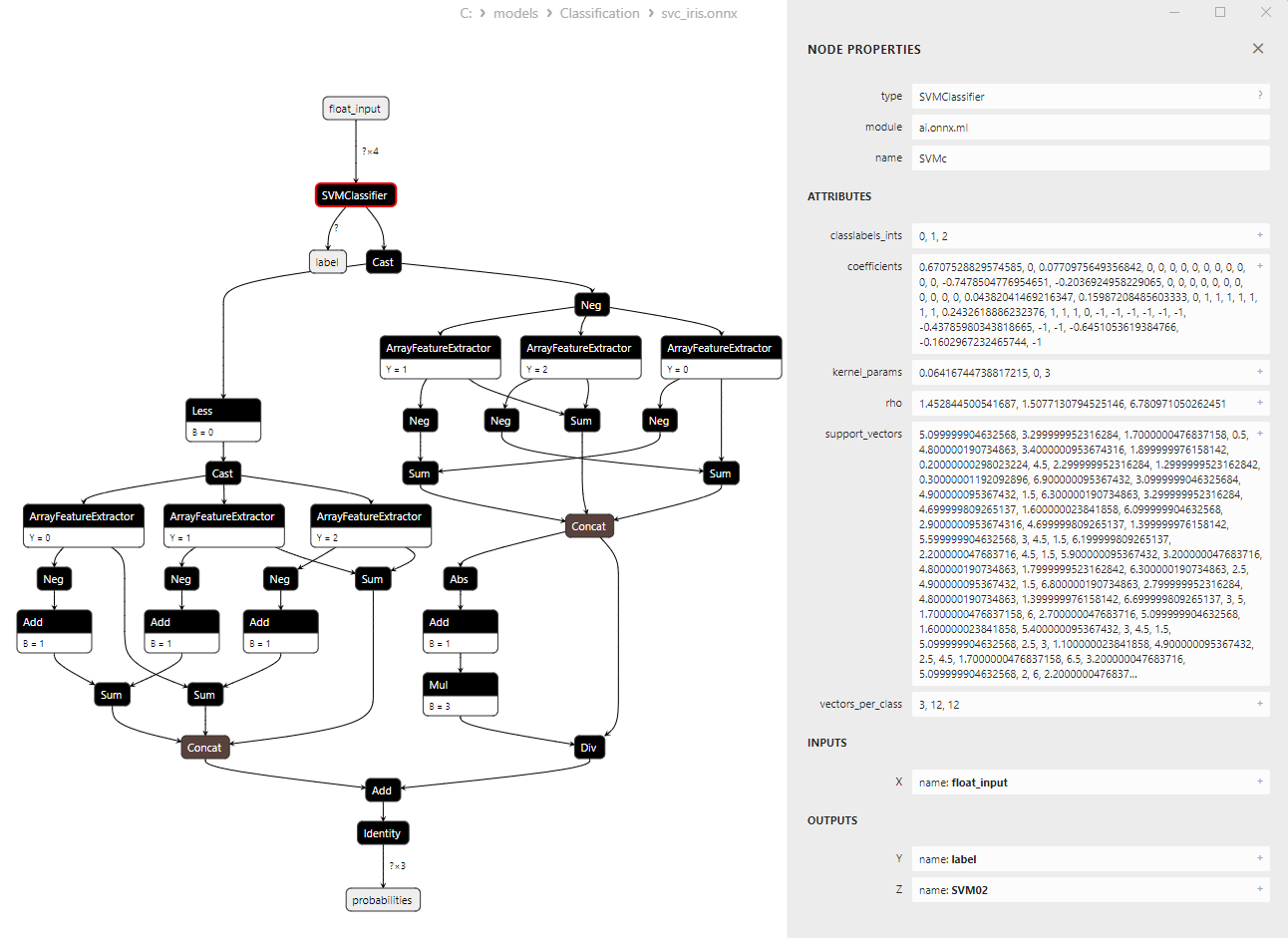

Pour obtenir des informations plus détaillées sur l'architecture du modèle, vous pouvez utiliser Netron. Pour cela, cliquez sur le bouton "Ouvrir dans Netron" dans la description du modèle dans MetaEditor.

Figure 14. Modèle ONNX svc_iris.onnx dans Netron

Figure 15. Modèle ONNX svc_iris.onnx dans Netron (SVMClassifier ONNX Operator Parameters)

2.2. Classificateur LinearSVC

LinearSVC (Linear Support Vector Classification) est un puissant algorithme d'apprentissage automatique utilisé pour les tâches de classification binaire et multi-classe. Il est basé sur l'idée de trouver un hyper-plan qui sépare au mieux les données.

Principes de LinearSVC :

- Recherche de l'hyper-plan optimal : L'idée principale de LinearSVC est de trouver l'hyper-plan optimal qui sépare au maximum les deux classes de données. Un hyper-plan est un plan multidimensionnel défini par une équation linéaire.

- Minimisation de la Marge : LinearSVC vise à minimiser les marges (les distances entre les points de données et l'hyper-plan). Plus les marges sont importantes, plus l'hyper-plan sépare efficacement les classes.

- Traitement de données linéairement non séparables : LinearSVC peut travailler avec des données qui ne peuvent pas être séparées linéairement dans l'espace des caractéristiques d'origine, grâce à l'utilisation de fonctions noyau (kernel trick) qui projettent les données dans un espace de dimension supérieure où elles peuvent être séparées linéairement.

Avantages de LinearSVC :

- Bonne Généralisation : LinearSVC a une bonne capacité de généralisation et peut donner de bons résultats sur de nouvelles données inédites.

- Efficacité : LinearSVC fonctionne rapidement sur de grands ensembles de données et nécessite relativement peu de ressources de calcul.

- Traitement de données linéairement non séparables : En utilisant des fonctions noyau, LinearSVC peut traiter des tâches de classification avec des données linéairement non séparables.

- Évolutivité : LinearSVC peut être utilisé efficacement dans les tâches comportant un grand nombre de caractéristiques et des volumes de données importants.

Limites de LinearSVC :

- Uniquement des hyper-plans de séparation linéaires : LinearSVC ne construit que des hyper-plans de séparation linéaires, ce qui peut s'avérer insuffisant pour les tâches de classification complexes comportant des dépendances non linéaires.

- Sélection des Paramètres : Le choix des bons paramètres (par exemple, le paramètre de régularisation) peut nécessiter des connaissances d'expert ou une validation croisée.

- Sensibilité aux valeurs aberrantes : LinearSVC peut être sensible aux valeurs aberrantes dans les données, ce qui peut affecter la qualité de la classification.

- Interprétabilité du modèle : Les modèles créés à l'aide de LinearSVC peuvent être moins faciles à interpréter que d'autres méthodes.

LinearSVC est un algorithme de classification puissant qui excelle dans la généralisation, l'efficacité et le traitement de données linéairement non séparables. Il trouve des applications dans diverses tâches de classification, en particulier lorsque les données peuvent être séparées par un hyper-plan linéaire. Mais pour les tâches complexes qui nécessitent la modélisation de dépendances non linéaires, LinearSVC peut s'avérer moins adapté. Dans ce cas, il convient d'envisager d'autres méthodes avec des limites de décision plus complexes.

2.2.1. Code pour la Création du Modèle de Classification LinearSVC

Ce code démontre le processus d'entraînement d'un modèle de classification LinearSVC sur le jeu de données Iris, l'exportant au format ONNX, et effectuant la classification en utilisant le modèle ONNX. Il évalue également la précision du modèle original et du modèle ONNX.

# Iris_LinearSVC.py # The code demonstrates the process of training LinearSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import LinearSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a LinearSVC model linear_svc_model = LinearSVC(C=1.0, max_iter=10000) # train the model on the entire dataset linear_svc_model.fit(X, y) # predict classes for the entire dataset y_pred = linear_svc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of LinearSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(linear_svc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "linear_svc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of LinearSVC model in ONNX format:", accuracy_onnx)

Sortie :

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.96 0.94 0.95 50

Python 2 0.94 0.96 0.95 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\linear_svc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of LinearSVC model in ONNX format: 0.9666666666666667

2.2.2. Code MQL5 pour Travailler avec le Modèle de Classification LinearSVC

//+------------------------------------------------------------------+ //| Iris_LinearSVC.mq5 | //| Copyright 2023, MetaQuotes Ltd. | //| https://www.mql5.com | //+------------------------------------------------------------------+ #property copyright "Copyright 2023, MetaQuotes Ltd." #property link "https://www.mql5.com" #property version "1.00" #include "iris.mqh" #resource "linear_svc_iris.onnx" as const uchar ExtModel[]; //+------------------------------------------------------------------+ //| Test IRIS dataset samples | //+------------------------------------------------------------------+ bool TestSamples(long model,float &input_data[][4], int &model_classes_id[]) { //--- check number of input samples ulong batch_size=input_data.Range(0); if(batch_size==0) return(false); //--- prepare output array ArrayResize(model_classes_id,(int)batch_size); //--- ulong input_shape[]= { batch_size, input_data.Range(1)}; OnnxSetInputShape(model,0,input_shape); //--- int output1[]; float output2[][3]; //--- ArrayResize(output1,(int)batch_size); ArrayResize(output2,(int)batch_size); //--- ulong output_shape[]= {batch_size}; OnnxSetOutputShape(model,0,output_shape); //--- ulong output_shape2[]= {batch_size,3}; OnnxSetOutputShape(model,1,output_shape2); //--- bool res=OnnxRun(model,ONNX_DEBUG_LOGS,input_data,output1,output2); //--- classes are ready in output1[k]; if(res) { for(int k=0; k<(int)batch_size; k++) model_classes_id[k]=output1[k]; } //--- return(res); } //+------------------------------------------------------------------+ //| Test all samples from IRIS dataset (150) | //| Here we test all samples with batch=1, sample by sample | //+------------------------------------------------------------------+ bool TestAllIrisDataset(const long model,const string model_name,double &model_accuracy) { sIRISsample iris_samples[]; //--- load dataset from file PrepareIrisDataset(iris_samples); //--- test int total_samples=ArraySize(iris_samples); if(total_samples==0) { Print("iris dataset not prepared"); return(false); } //--- show dataset for(int k=0; k<total_samples; k++) { //PrintFormat("%d (%.2f,%.2f,%.2f,%.2f) class %d (%s)",iris_samples[k].sample_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3],iris_samples[k].class_id,iris_samples[k].class_name); } //--- array for output classes int model_output_classes_id[]; //--- check all Iris dataset samples int correct_results=0; for(int k=0; k<total_samples; k++) { //--- input array float iris_sample_input_data[1][4]; //--- prepare input data from kth iris sample dataset iris_sample_input_data[0][0]=(float)iris_samples[k].features[0]; iris_sample_input_data[0][1]=(float)iris_samples[k].features[1]; iris_sample_input_data[0][2]=(float)iris_samples[k].features[2]; iris_sample_input_data[0][3]=(float)iris_samples[k].features[3]; //--- run model bool res=TestSamples(model,iris_sample_input_data,model_output_classes_id); //--- check result if(res) { if(model_output_classes_id[0]==iris_samples[k].class_id) { correct_results++; } else { PrintFormat("model:%s sample=%d FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f]",model_name,iris_samples[k].sample_id,model_output_classes_id[0],iris_samples[k].class_id,iris_samples[k].features[0],iris_samples[k].features[1],iris_samples[k].features[2],iris_samples[k].features[3]); } } } model_accuracy=1.0*correct_results/total_samples; //--- PrintFormat("model:%s correct results: %.2f%%",model_name,100*model_accuracy); //--- return(true); } //+------------------------------------------------------------------+ //| Here we test batch execution of the model | //+------------------------------------------------------------------+ bool TestBatchExecution(const long model,const string model_name,double &model_accuracy) { model_accuracy=0; //--- array for output classes int model_output_classes_id[]; int correct_results=0; int total_results=0; bool res=false; //--- run batch with 3 samples float input_data_batch3[3][4]= { {5.1f,3.5f,1.4f,0.2f}, // iris dataset sample id=1, Iris-setosa {6.3f,2.5f,4.9f,1.5f}, // iris dataset sample id=73, Iris-versicolor {6.3f,2.7f,4.9f,1.8f} // iris dataset sample id=124, Iris-virginica }; int correct_classes_batch3[3]= {0,1,2}; //--- run model res=TestSamples(model,input_data_batch3,model_output_classes_id); if(res) { //--- check result for(int j=0; j<ArraySize(model_output_classes_id); j++) { //--- check result if(model_output_classes_id[j]==correct_classes_batch3[j]) correct_results++; else { PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch3[j],input_data_batch3[j][0],input_data_batch3[j][1],input_data_batch3[j][2],input_data_batch3[j][3]); } total_results++; } } else return(false); //--- run batch with 10 samples float input_data_batch10[10][4]= { {5.5f,3.5f,1.3f,0.2f}, // iris dataset sample id=37 (Iris-setosa) {4.9f,3.1f,1.5f,0.1f}, // iris dataset sample id=38 (Iris-setosa) {4.4f,3.0f,1.3f,0.2f}, // iris dataset sample id=39 (Iris-setosa) {5.0f,3.3f,1.4f,0.2f}, // iris dataset sample id=50 (Iris-setosa) {7.0f,3.2f,4.7f,1.4f}, // iris dataset sample id=51 (Iris-versicolor) {6.4f,3.2f,4.5f,1.5f}, // iris dataset sample id=52 (Iris-versicolor) {6.3f,3.3f,6.0f,2.5f}, // iris dataset sample id=101 (Iris-virginica) {5.8f,2.7f,5.1f,1.9f}, // iris dataset sample id=102 (Iris-virginica) {7.1f,3.0f,5.9f,2.1f}, // iris dataset sample id=103 (Iris-virginica) {6.3f,2.9f,5.6f,1.8f} // iris dataset sample id=104 (Iris-virginica) }; //--- correct classes for all 10 samples in the batch int correct_classes_batch10[10]= {0,0,0,0,1,1,2,2,2,2}; //--- run model res=TestSamples(model,input_data_batch10,model_output_classes_id); //--- check result if(res) { for(int j=0; j<ArraySize(model_output_classes_id); j++) { if(model_output_classes_id[j]==correct_classes_batch10[j]) correct_results++; else { double f1=input_data_batch10[j][0]; double f2=input_data_batch10[j][1]; double f3=input_data_batch10[j][2]; double f4=input_data_batch10[j][3]; PrintFormat("model:%s FAILED [class=%d, true class=%d] features=(%.2f,%.2f,%.2f,%.2f)",model_name,model_output_classes_id[j],correct_classes_batch10[j],input_data_batch10[j][0],input_data_batch10[j][1],input_data_batch10[j][2],input_data_batch10[j][3]); } total_results++; } } else return(false); //--- calculate accuracy model_accuracy=correct_results/total_results; //--- return(res); } //+------------------------------------------------------------------+ //| Script program start function | //+------------------------------------------------------------------+ int OnStart(void) { string model_name="LinearSVC"; //--- long model=OnnxCreateFromBuffer(ExtModel,ONNX_DEFAULT); if(model==INVALID_HANDLE) { PrintFormat("model_name=%s OnnxCreate error %d for",model_name,GetLastError()); } else { //--- test all dataset double model_accuracy=0; //-- test sample by sample execution for all Iris dataset if(TestAllIrisDataset(model,model_name,model_accuracy)) PrintFormat("model=%s all samples accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- test batch execution for several samples if(TestBatchExecution(model,model_name,model_accuracy)) PrintFormat("model=%s batch test accuracy=%f",model_name,model_accuracy); else PrintFormat("error in testing model=%s ",model_name); //--- release model OnnxRelease(model); } return(0); } //+------------------------------------------------------------------+

Sortie :

Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=71 FAILED [class=2, true class=1] features=(5.90,3.20,4.80,1.80] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=84 FAILED [class=2, true class=1] features=(6.00,2.70,5.10,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=85 FAILED [class=2, true class=1] features=(5.40,3.00,4.50,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=130 FAILED [class=1, true class=2] features=(7.20,3.00,5.80,1.60] Iris_LinearSVC (EURUSD,H1) model:LinearSVC sample=134 FAILED [class=1, true class=2] features=(6.30,2.80,5.10,1.50] Iris_LinearSVC (EURUSD,H1) model:LinearSVC correct results: 96.67% Iris_LinearSVC (EURUSD,H1) model=LinearSVC all samples accuracy=0.966667 Iris_LinearSVC (EURUSD,H1) model=LinearSVC batch test accuracy=1.000000

La précision du modèle ONNX exporté sur l'ensemble du jeu de données Iris est de 96,67 %, ce qui correspond à la précision du modèle original.

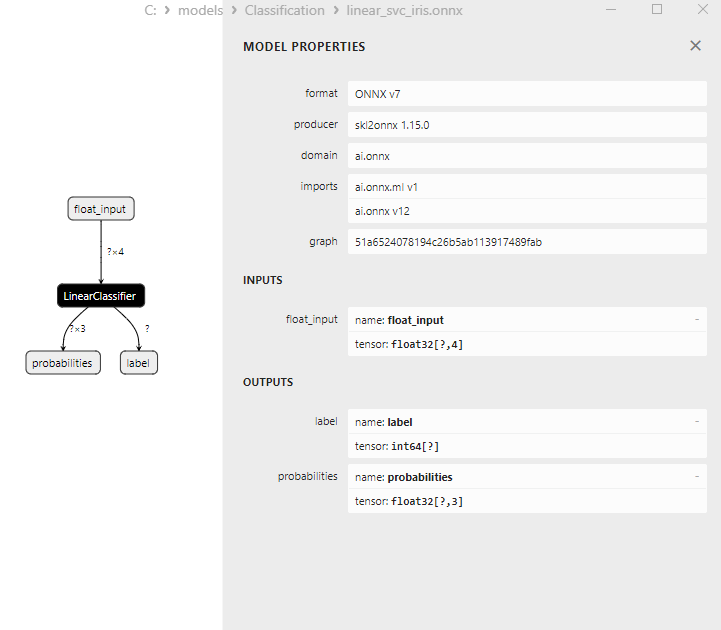

2.2.3. Représentation ONNX du Modèle de Classification LinearSVC

Figure 16. Représentation ONNX du Modèle de Classification LinearSVC dans Netron

2.3. Classificateur NuSVC

La méthode Nu-Support Vector Classification (NuSVC) est un puissant algorithme d'apprentissage automatique basé sur l'approche Support Vector Machine (SVM).

Principes de NuSVC :

- Support Vector Machine (SVM) : NuSVC est une variante des SVM utilisée pour les tâches de classification binaire et multi-classe. Le principe de base des SVM est de trouver l'hyper-plan de séparation optimal qui sépare au maximum les classes tout en conservant une marge maximale.

- Le Paramètre Nu : Un paramètre clé de NuSVC est le paramètre Nu (nu), qui contrôle la complexité du modèle et définit la proportion de l'échantillon qui peut être utilisée comme vecteurs de support et d'erreurs. La valeur de Nu est comprise entre 0 et 1, où 0,5 signifiant qu'environ la moitié de l'échantillon sera utilisée comme vecteurs de support et d'erreurs.

- Réglage des Paramètres : La détermination des valeurs optimales du paramètre Nu et d'autres hyper-paramètres peut nécessiter une validation croisée et une recherche des meilleures valeurs sur les données d'apprentissage.

- Fonctions Noyau : NuSVC peut utiliser différentes fonctions noyau telles que la fonction linéaire, la fonction de base radiale (RBF), la fonction polynomiale, etc. La fonction noyau détermine la façon dont l'espace des caractéristiques est transformé pour trouver l'hyper-plan de séparation.

Avantages de NuSVC :

- Efficacité dans les Espaces à Haute Dimension : NuSVC peut travailler efficacement dans des espaces à haute dimension, ce qui le rend adapté aux tâches comportant un grand nombre de caractéristiques.

- Robustesse face aux valeurs aberrantes : Les SVM, et NuSVC en particulier, sont résistants aux données aberrantes grâce à l'utilisation de vecteurs de support.

- Contrôle de la Complexité du Modèle : Le paramètre Nu permet de contrôler la complexité du modèle et d'équilibrer l'adaptation aux données et la généralisation.

- Bonne Généralisation : Les SVM et NuSVC, en particulier, font preuve d'une bonne généralisation, ce qui se traduit par d'excellentes performances sur des données nouvelles, jamais vues auparavant.

Limites de NuSVC :

- Inefficacité Avec de Grands Volumes de Données : NuSVC peut être inefficace lorsqu'il est entraîné sur de grands volumes de données en raison de la complexité des calculs.

- Réglage des Paramètres Requis : L'ajustement du paramètre Nu et de la fonction noyau peut nécessiter du temps et des ressources de calcul.

- Linéarité de la Fonction du Noyau : L'efficacité de NuSVC peut dépendre de manière significative du choix de la fonction noyau, et pour certaines tâches, il peut être nécessaire d'expérimenter différentes fonctions.

- Interprétabilité du Modèle : SVM et NuSVC fournissent d'excellents résultats, mais leurs modèles peuvent être complexes à interpréter, en particulier lorsque des noyaux non linéaires sont utilisés.

La classification vectorielle Nu-Support (NuSVC) est une méthode de classification puissante basée sur les SVM qui présente plusieurs avantages, notamment la robustesse aux valeurs aberrantes et une bonne généralisation. Mais son efficacité dépend de la sélection des paramètres et de la fonction du noyau, et elle peut être inefficace pour les grands volumes de données. Il est essentiel de sélectionner soigneusement les paramètres et d'adapter la méthode à des tâches de classification spécifiques.

2.3.1. Code de Création du Modèle de Classification NuSVC

Ce code démontre le processus d'entraînement d'un modèle de Classification NuSVC sur le jeu de données Iris, son export au format ONNX et la réalisation d'une classification à l'aide du modèle ONNX. Il évalue également la précision du modèle original et du modèle ONNX.

# Iris_NuSVC.py # The code demonstrates the process of training NuSVC model on the Iris dataset, exporting it to ONNX format, and making predictions using the ONNX model. # It also evaluates the accuracy of both the original model and the ONNX model. # Copyright 2023, MetaQuotes Ltd. # https://www.mql5.com # import necessary libraries from sklearn import datasets from sklearn.svm import NuSVC from sklearn.metrics import accuracy_score, classification_report from skl2onnx import convert_sklearn from skl2onnx.common.data_types import FloatTensorType import onnxruntime as ort import numpy as np from sys import argv # define the path for saving the model data_path = argv[0] last_index = data_path.rfind("\\") + 1 data_path = data_path[0:last_index] # load the Iris dataset iris = datasets.load_iris() X = iris.data y = iris.target # create a NuSVC model nusvc_model = NuSVC(nu=0.5, kernel='linear') # train the model on the entire dataset nusvc_model.fit(X, y) # predict classes for the entire dataset y_pred = nusvc_model.predict(X) # evaluate the model's accuracy accuracy = accuracy_score(y, y_pred) print("Accuracy of NuSVC model:", accuracy) # display the classification report print("\nClassification Report:\n", classification_report(y, y_pred)) # define the input data type initial_type = [('float_input', FloatTensorType([None, X.shape[1]]))] # export the model to ONNX format with float data type onnx_model = convert_sklearn(nusvc_model, initial_types=initial_type, target_opset=12) # save the model to a file onnx_filename = data_path + "nusvc_iris.onnx" with open(onnx_filename, "wb") as f: f.write(onnx_model.SerializeToString()) # print model path print(f"Model saved to {onnx_filename}") # load the ONNX model and make predictions onnx_session = ort.InferenceSession(onnx_filename) input_name = onnx_session.get_inputs()[0].name output_name = onnx_session.get_outputs()[0].name # display information about input tensors in ONNX print("\nInformation about input tensors in ONNX:") for i, input_tensor in enumerate(onnx_session.get_inputs()): print(f"{i + 1}. Name: {input_tensor.name}, Data Type: {input_tensor.type}, Shape: {input_tensor.shape}") # display information about output tensors in ONNX print("\nInformation about output tensors in ONNX:") for i, output_tensor in enumerate(onnx_session.get_outputs()): print(f"{i + 1}. Name: {output_tensor.name}, Data Type: {output_tensor.type}, Shape: {output_tensor.shape}") # convert data to floating-point format (float32) X_float32 = X.astype(np.float32) # predict classes for the entire dataset using ONNX y_pred_onnx = onnx_session.run([output_name], {input_name: X_float32})[0] # evaluate the accuracy of the ONNX model accuracy_onnx = accuracy_score(y, y_pred_onnx) print("\nAccuracy of NuSVC model in ONNX format:", accuracy_onnx)

Sortie :

Python

Python Classification Report:

Python precision recall f1-score support

Python

Python 0 1.00 1.00 1.00 50

Python 1 0.96 0.96 0.96 50

Python 2 0.96 0.96 0.96 50

Python

Python accuracy 0.97 150

Python macro avg 0.97 0.97 0.97 150

Python weighted avg 0.97 0.97 0.97 150

Python

Python Model saved to C:\Users\user\AppData\Roaming\MetaQuotes\Terminal\D0E8209F77C8CF37AD8BF550E51FF075\MQL5\Scripts\nusvc_iris.onnx

Python

Python Information about input tensors in ONNX:

Python 1. Name: float_input, Data Type: tensor(float), Shape: [None, 4]

Python

Python Information about output tensors in ONNX:

Python 1. Name: label, Data Type: tensor(int64), Shape: [None]

Python 2. Name: probabilities, Data Type: tensor(float), Shape: [None, 3]

Python

Python Accuracy of NuSVC model in ONNX format: 0.9733333333333334

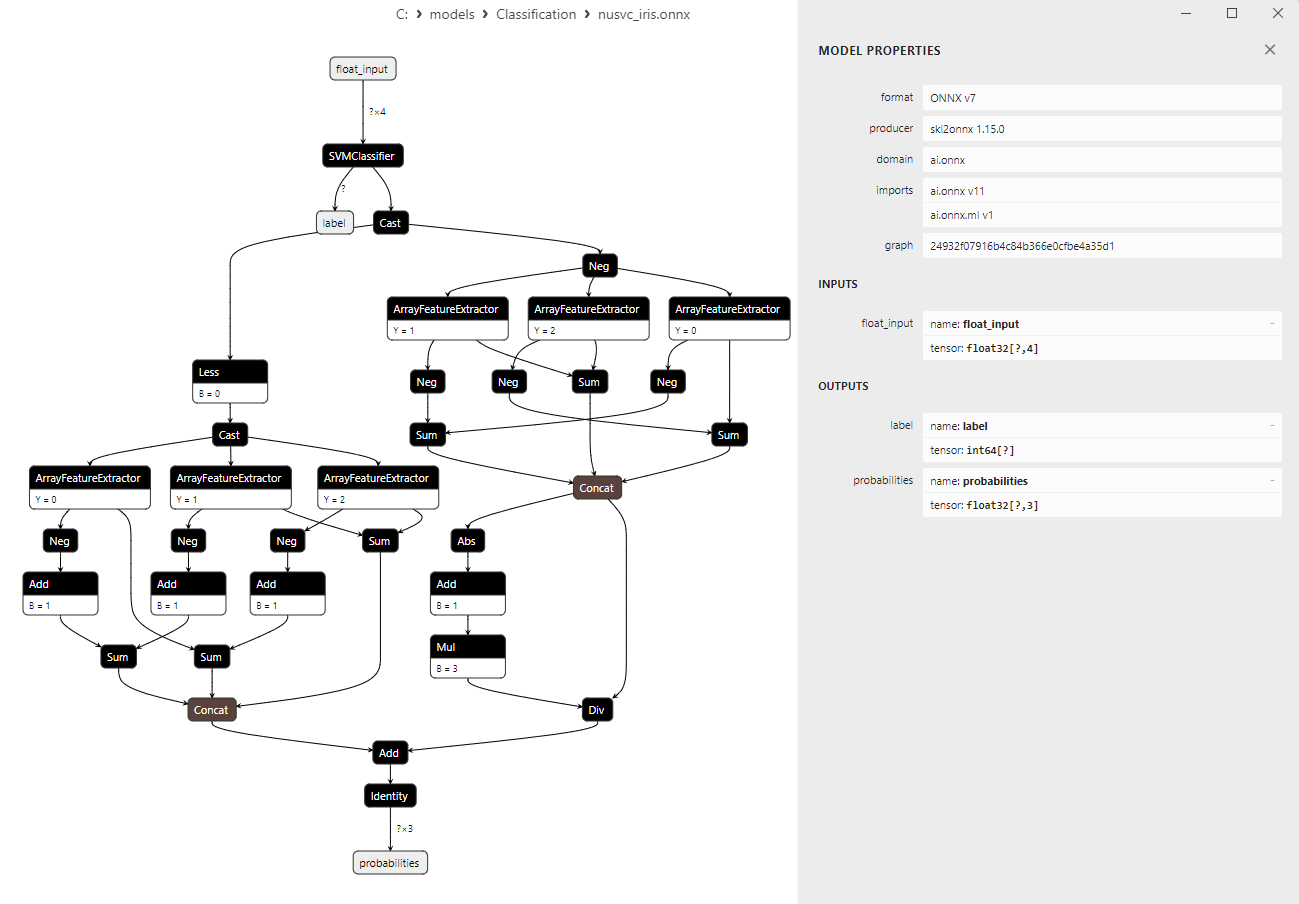

2.3.2. Code MQL5 pour Travailler avec le Modèle de Classification NuSVC